01-Dubbo核心基础

01-Dubbo核心基础

学习核心

- ① dubbo 源码环境搭建

- ② dubbo 的配置总线

- ③ dubbo SPI 剖析

- ④ 海量定时任务:时间轮

- ⑤ Zookeeper & Curator

- ⑥ 代理模式设计与实现

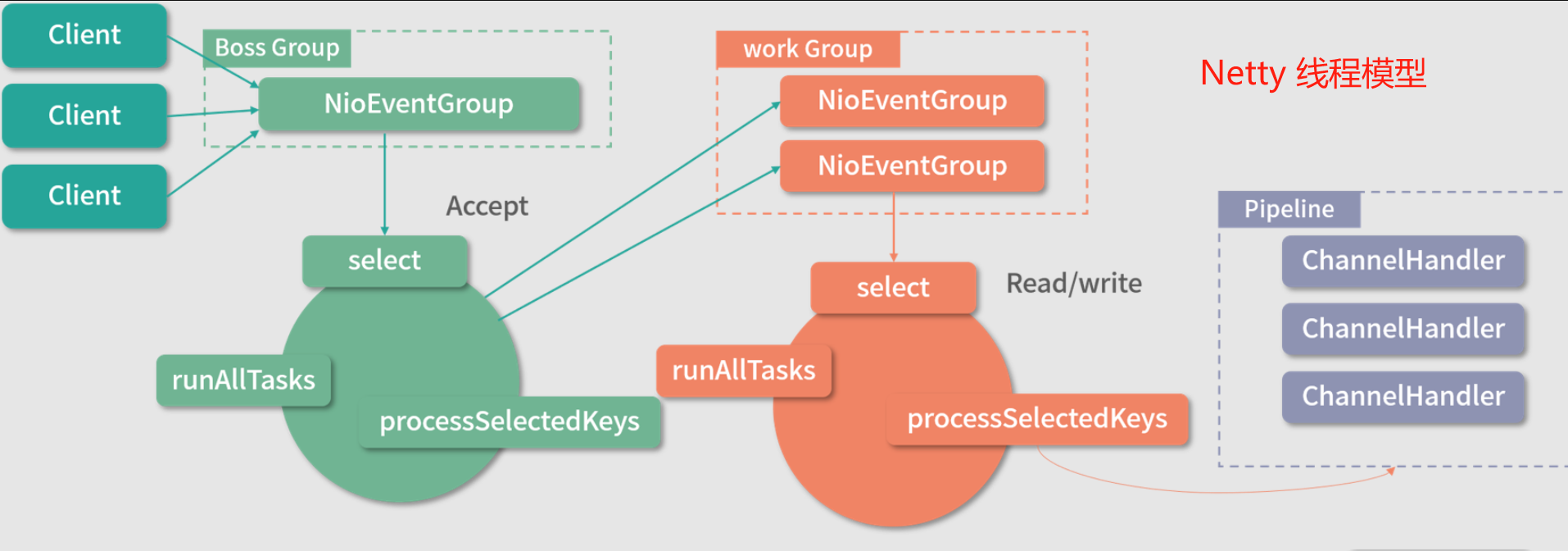

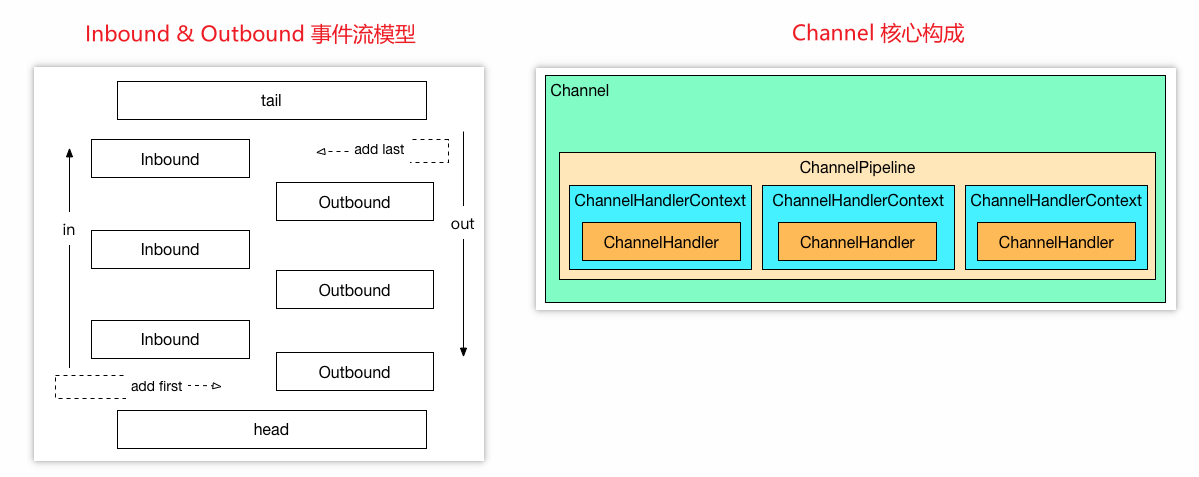

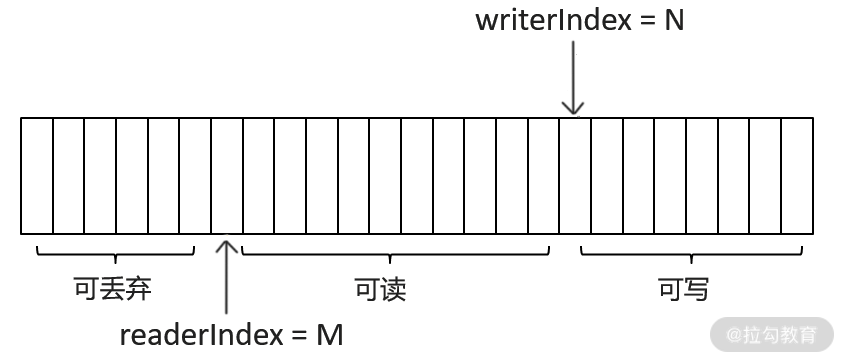

- ⑦ Netty 入门核心

- ⑧ 简易版RPC框架实现

学习资料

- Dubbo源码解读与实战

- 相关源码参考

noob-rpc/dubbo-demo下的项目工程源码

环境搭建

① dubbo 源码环境搭建

学习目标

- 整理梳理Dubbo架构,帮助了解Dubbo基本功能和核心角色

- 搭建Dubbo源码环境,构建一个Demo实例可运行的最简环境

- 深入学习Dubbo源码中各个核心模块的功能

- 基于Dubbo源码自带的3个demo实例,回顾dubbo的基础用法(debug剖析源码的入口)

xmlannotationapi

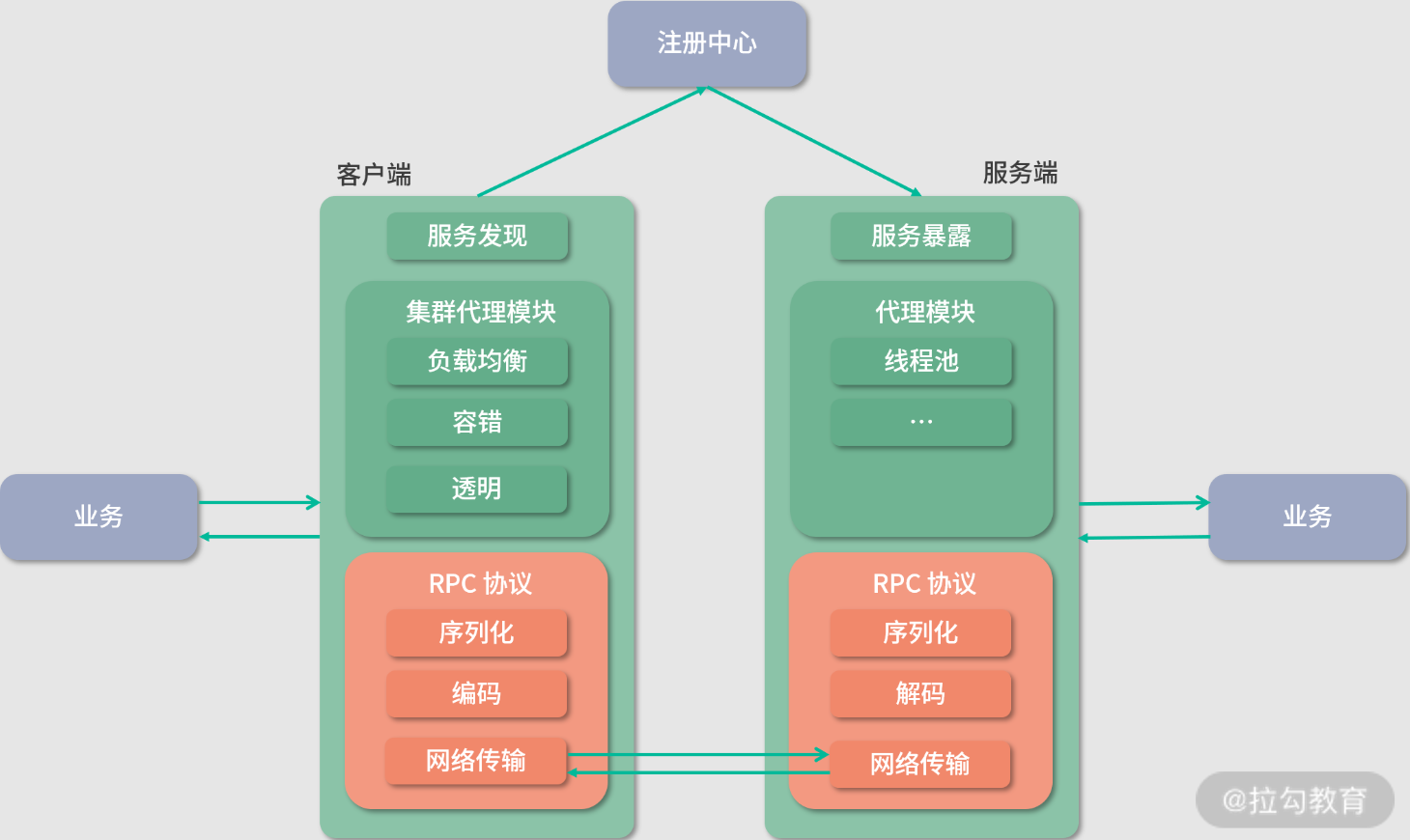

1.Dubbo 架构

Dubbo 架构核心:Registry 注册中心、Provider 服务提供者、Consumer 服务消费者、Monitor 监控中心

- Registry:注册中心。 负责服务地址的注册与查找,服务的 Provider 和 Consumer 只在启动时与注册中心交互。注册中心通过长连接感知 Provider 的存在,在 Provider 出现宕机的时候,注册中心会立即推送相关事件通知 Consumer。

- Provider:服务提供者。 在它启动的时候,会向 Registry 进行注册操作,将自己服务的地址和相关配置信息封装成 URL 添加到 ZooKeeper 中。

- Consumer:服务消费者。 在它启动的时候,会向 Registry 进行订阅操作。订阅操作会从 ZooKeeper 中获取 Provider 注册的 URL,并在 ZooKeeper 中添加相应的监听器。获取到 Provider URL 之后,Consumer 会根据负载均衡算法从多个 Provider 中选择一个 Provider 并与其建立连接,最后发起对 Provider 的 RPC 调用。 如果 Provider URL 发生变更,Consumer 将会通过之前订阅过程中在注册中心添加的监听器,获取到最新的 Provider URL 信息,进行相应的调整,比如断开与宕机 Provider 的连接,并与新的 Provider 建立连接。Consumer 与 Provider 建立的是长连接,且 Consumer 会缓存 Provider 信息,所以一旦连接建立,即使注册中心宕机,也不会影响已运行的 Provider 和 Consumer。

- Monitor:监控中心。 用于统计服务的调用次数和调用时间。Provider 和 Consumer 在运行过程中,会在内存中统计调用次数和调用时间,定时每分钟发送一次统计数据到监控中心。监控中心在上面的架构图中并不是必要角色,监控中心宕机不会影响 Provider、Consumer 以及 Registry 的功能,只会丢失监控数据而已。

2.Dubbo 源码环境搭建

⚽ Dubbo 源码环境搭建

可以直接从dubbo官方源码仓库直接fork到自己的仓库(参考dubbo-2.7.7版本)

① 下载源码:git clone git@github.com:xxxxxxxx/dubbo.git

② 切换分支:git checkout -b dubbo-2.7.7 dubbo-2.7.7 (切换到指定的版本)

③ mvn编译:mvn clean install -Dmaven.test.skip=true

④ mvn转化为IDEA项目:mvn idea:idea (要是执行报错,就执行这个 mvn idea:workspace )

⑤ 在idea中导入源码

⚽ Dubbo 源码核心模块

(1)dubbo-common 模块

Dubbo 的一个公共模块,其中有很多工具类以及公共逻辑,包括后续要学习的 Dubbo SPI 实现、时间轮实现、动态编译器等

(2)dubbo-remoting 模块

Dubbo 的远程通信模块,其中的子模块依赖各种开源组件实现远程通信。在 dubbo-remoting-api 子模块中定义该模块的抽象概念,在其他子模块中依赖其他开源组件进行实现,例如,dubbo-remoting-netty4 子模块依赖 Netty 4 实现远程通信,dubbo-remoting-zookeeper 通过 Apache Curator 实现与 ZooKeeper 集群的交互。

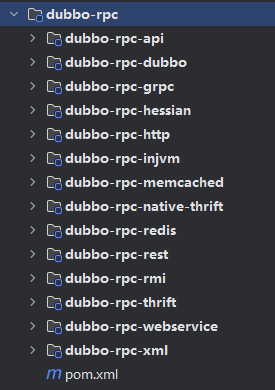

(3)dubbo-rpc 模块

Dubbo 中对远程调用协议进行抽象的模块,其中抽象了各种协议,依赖于 dubbo-remoting 模块的远程调用功能。dubbo-rpc-api 子模块是核心抽象,其他子模块是针对具体协议的实现,例如,dubbo-rpc-dubbo 子模块是对 Dubbo 协议的实现,依赖了 dubbo-remoting-netty4 等 dubbo-remoting 子模块。 dubbo-rpc 模块的实现中只包含一对一的调用,不关心集群的相关内容

(4)dubbo-cluster 模块

Dubbo 中负责管理集群的模块,提供了负载均衡、容错、路由等一系列集群相关的功能,最终的目的是将多个 Provider 伪装为一个 Provider,这样 Consumer 就可以像调用一个 Provider 那样调用 Provider 集群了

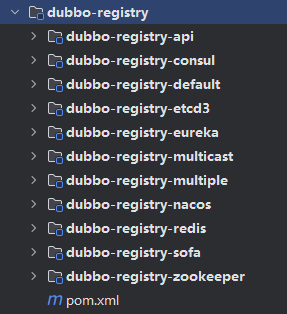

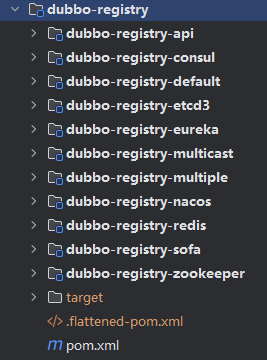

(5)dubbo-registry 模块

Dubbo 中负责与多种开源注册中心进行交互的模块,提供注册中心的能力。其中, dubbo-registry-api 子模块是顶层抽象,其他子模块是针对具体开源注册中心组件的具体实现,例如,dubbo-registry-zookeeper 子模块是 Dubbo 接入 ZooKeeper 的具体实现

(6)dubbo-monitor 模块

Dubbo 的监控模块,主要用于统计服务调用次数、调用时间以及实现调用链跟踪的服务。

(7)dubbo-config 模块

Dubbo 对外暴露的配置都是由该模块进行解析的。例如,dubbo-config-api 子模块负责处理 API 方式使用时的相关配置,dubbo-config-spring 子模块负责处理与 Spring 集成使用时的相关配置方式。有了 dubbo-config 模块,用户只需要了解 Dubbo 配置的规则即可,无须了解 Dubbo 内部的细节。

(8)dubbo-metadata 模块

Dubbo 的元数据模块。dubbo-metadata 模块的实现套路也是有一个 api 子模块进行抽象,然后其他子模块进行具体实现

(9)dubbo-configcenter 模块

Dubbo 的动态配置模块,主要负责外部化配置以及服务治理规则的存储与通知,提供了多个子模块用来接入多种开源的服务发现组件

(10)dubbo-demo

Dubbo 源码提供的demo示例,共包括三个非常基础 的 Dubbo 示例项目,分别是: 使用 XML 配置的 Demo 示例、使用注解配置的 Demo 示例 以及 直接使用 API 的 Demo 示例 。从这三个示例的角度,简单介绍 Dubbo 的基本使用。同时,这三个项目也将作为后续 Debug Dubbo 源码的入口,在后续的学习中会根据需要在其之上进行修改 。不过在这儿之前,需要先启动 ZooKeeper 作为注册中心,然后编写一个业务接口作为 Provider 和 Consumer 的公约。

⚽ Dubbo-demo 测试

环境配置说明

- Zookeeper(3.4.14版本)

- JDK 8(如果demo启动错误,考虑版本兼容性问题,此处用JDK8进行版本测试)

- dubbo - 2.7.x

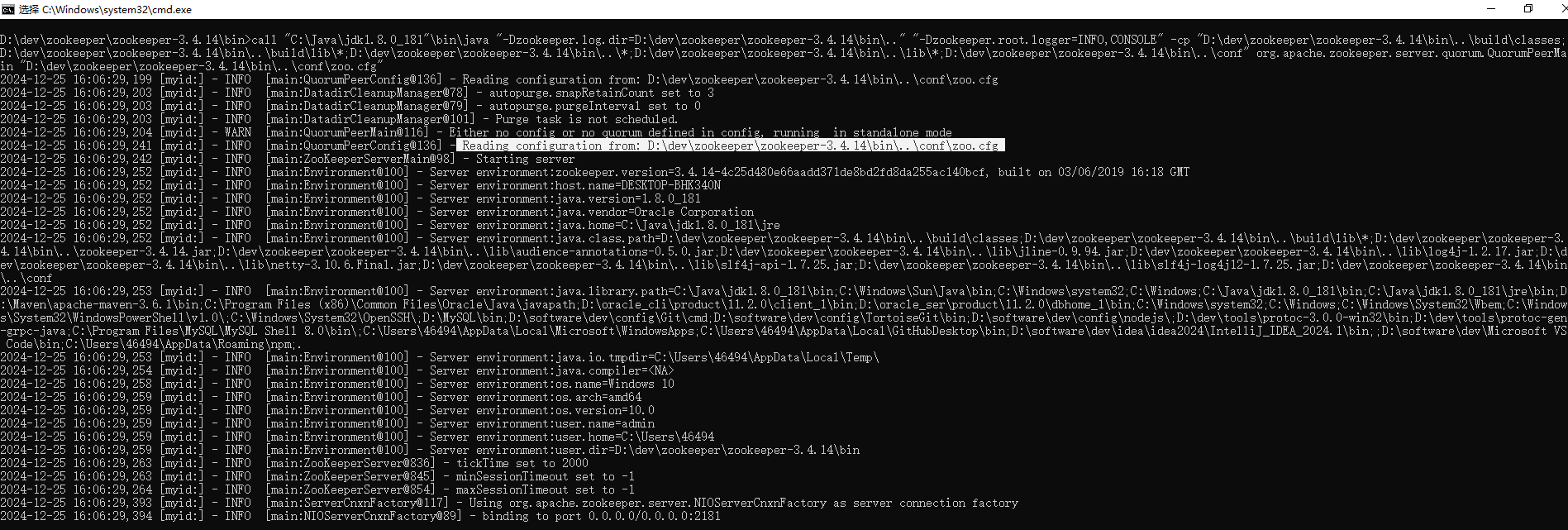

(1)本地Zookeeper环境搭建

结合Dubbo架构图可知, Provider 的地址以及配置信息是通过注册中心传递给 Consumer 的。 Dubbo 支持的注册中心尽管有很多, 但在生产环境中, 基本都是用 ZooKeeper 作为注册中心 。因此,在调试 Dubbo 源码时,自然需要在本地启动 ZooKeeper。

本地Zookeeper环境搭建(windows)

① 下载并解压 zookeeper-3.4.14.tar.gz 包(

tar -zxf zookeeper-3.4.14.tar.gz)② 进入

zk目录,将conf/zoo_sample.cfgcopy一份并重命名conf/zoo.cfg,随后启动Zookeeper./bin/zkServer.sh startwindow 下可以直接执行

zkServer.cmd(注意windows下不是zkServer.cmd start,而是zkServer.cmd(否则启动提示报错))

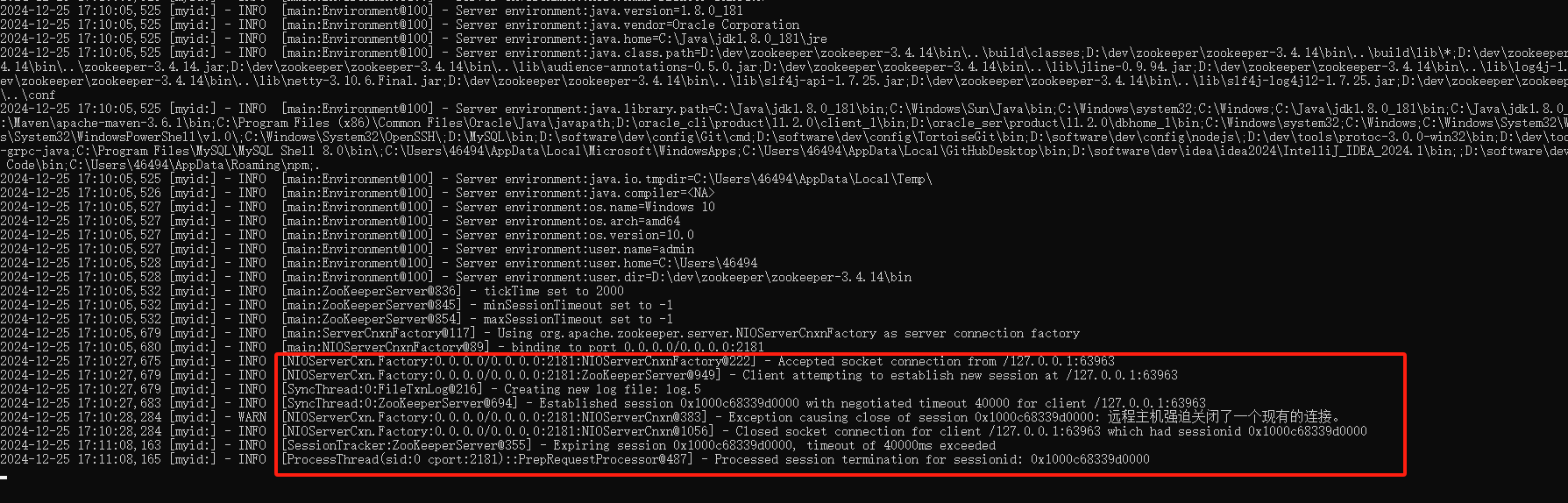

如果在demo启动的时候提示zookeeper not connected则尝试关闭窗口重启zookeeper后尝试(有可能是zookeeper没有启动成功,也有可能是连接zookeeper超时导致异常触发)。正常来说,如果demo(例如provider启动连接zookeeper)启动尝试连接zookeeper时,相应cmd窗口会有信息提示,如果没有(可能程序一直卡在那里),则需要关闭窗口尝试重新启动zookeeper

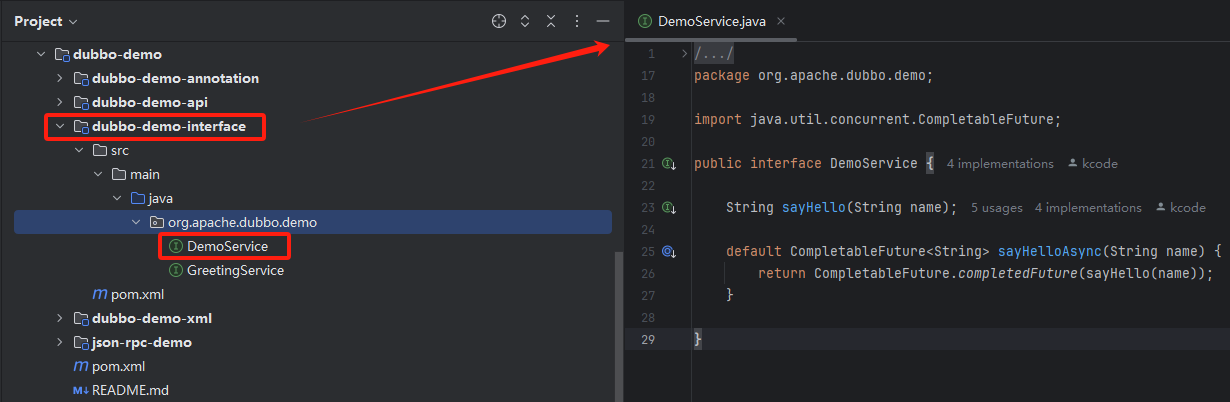

(2)业务接口

在使用 Dubbo 之前,还需要一个业务接口,这个业务接口可以认为是 Dubbo Provider 和 Dubbo Consumer 的公约,反映出很多信息:

- Provider ,如何提供服务、提供的服务名称是什么、需要接收什么参数、需要返回什么响应;

- Consumer ,如何使用服务、使用的服务名称是什么、需要传入什么参数、会得到什么响应;

dubbo-demo-interface 模块就是定义业务接口的地方,如下图所示:

且需要将这些公约接口导入到仓库中,执行指令mvn clean install -Dmaven.test.skip=true进行编译

(3)不同形式的 Provider & Consumer 实现

① 基于XML配置dubbo-demo-xml

在 dubbo-demo 模块下的 dubbo-demo-xml 模块,提供了基于 Spring XML 的 Provider 和 Consumer

- Provider 配置核心

- ①

pom.xml配置:依赖dubbo-demo-interface公共接口(接口公约) - ② 实现服务接口:

DemoServiceImpl接口实现(以构建服务接口DemoService为例) - ③

dubbo-provider.xml配置:spring 配置文件,基于xml形式配置接口服务相关内容:注册中心配置、要暴露的接口定义 - ④ 启动类:

Application配置,加载指定配置文件并启动接口服务

- ①

- Consumer 配置核心

- ①

pom.xml配置:依赖dubbo-demo-interface公共接口(接口公约) - ②

dubbo-consumer.xml配置:spring 配置文件,基于xml形式配置服务发现相关内容:配置要引用的接口服务 - ③ 启动类:

Application配置,加载指定配置文件并启动消费服务

- ①

Provider 实现:dubbo-demo-xml-provider

①

pom.xml配置:除了一堆dubbo的依赖之外,还依赖dubbo-demo-interface这个公共接口<dependency> <groupId>org.apache.dubbo</groupId> <artifactId>dubbo-demo-interface</artifactId> <version>${project.parent.version}</version> </dependency>②

DemoServiceImpl接口实现:自定义DemoServiceImpl实现DemoService接口的sayHello同步方法和sayHelloAsync异步方法public class DemoServiceImpl implements DemoService { private static final Logger logger = LoggerFactory.getLogger(DemoServiceImpl.class); @Override public String sayHello(String name) { logger.info("Hello " + name + ", request from consumer: " + RpcContext.getContext().getRemoteAddress()); return "Hello " + name + ", response from provider: " + RpcContext.getContext().getLocalAddress(); } @Override public CompletableFuture<String> sayHelloAsync(String name) { CompletableFuture<String> cf = CompletableFuture.supplyAsync(() -> { return "async result"; }); return cf; } }③

dubbo-provider.xml配置:bean 配置:在

dubbo-provider.xml将DemoServiceImpl配置为一个Spring bean 并将其作为DemoService服务暴露出去<!-- 配置Spring Bean --> <bean id="demoService" class="org.apache.dubbo.demo.provider.DemoServiceImpl"/> <!-- 将demoService作为服务发布出去--> <dubbo:service interface="org.apache.dubbo.demo.DemoService" ref="demoService"/>注册中心配置:配置Zookeeper注册中心地址,将要暴露的服务注册到ZK中

<!-- zookeeper 注册中心地址配置 --> <dubbo:registry address="zookeeper://127.0.0.1:2181"/>

④

Application配置:在启动类main方法中指定Spring配置文件并启动ClassPathXmlApplicationContextpublic class Application { public static void main(String[] args) throws Exception { ClassPathXmlApplicationContext context = new ClassPathXmlApplicationContext("spring/dubbo-provider.xml"); context.start(); System.in.read(); } }

Consumer 实现:dubbo-demo-xml-consumer

①

pom.xml配置:除了一堆dubbo的依赖之外,还依赖dubbo-demo-interface这个公共接口(服务提供方和服务调用方的接口公约)<dependency> <groupId>org.apache.dubbo</groupId> <artifactId>dubbo-demo-interface</artifactId> <version>${project.parent.version}</version> </dependency>②

dubbo-consumer.xml配置:dubbo-reference引入服务<!--引入DemoService服务,并配置成Spring Bean--> <dubbo:reference id="demoService" check="false" interface="org.apache.dubbo.demo.DemoService"/>配置zookeeper注册中心地址

<!-- Zookeeper地址 --> <dubbo:registry address="zookeeper://127.0.0.1:2181"/>

③

Application配置:在启动类main方法中指定Spring配置文件并启动ClassPathXmlApplicationContextpublic class Application { /** * In order to make sure multicast registry works, need to specify '-Djava.net.preferIPv4Stack=true' before * launch the application */ public static void main(String[] args) throws Exception { ClassPathXmlApplicationContext context = new ClassPathXmlApplicationContext("spring/dubbo-consumer.xml"); context.start(); DemoService demoService = context.getBean("demoService", DemoService.class); String hello = demoService.sayHello("world"); System.out.println("result: " + hello); } }

启动测试:先Provider、后Consumer

① Provider 启动成功:信息提示

[25/12/24 17:21:13:660 CST] main INFO metadata.DynamicConfigurationServiceNameMapping: [DUBBO] Dubbo service[null] mapped to interface name[org.apache.dubbo.demo.DemoService]., dubbo version: , current host: 172.19.30.91

[25/12/24 17:21:13:670 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap is ready., dubbo version: , current host: 172.19.30.91

[25/12/24 17:21:13:670 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap has started., dubbo version: , current host: 172.19.30.91

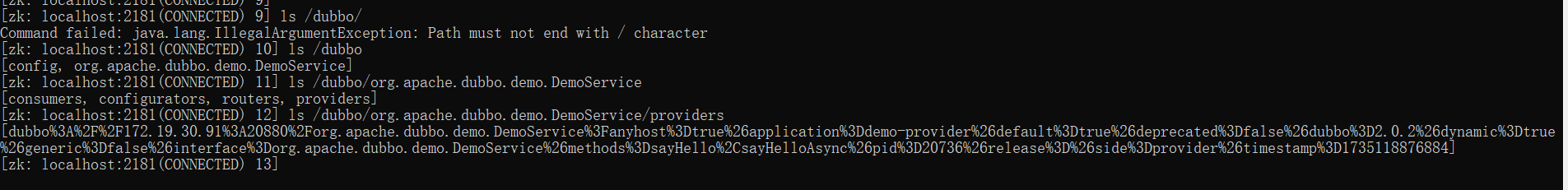

可以启动ZkCli.cmd通过ls /查看节点是否注册成功

DubboAdmin

② Consumer 启动成功:信息提示(可以正常调用服务接口并响应结果)

[26/12/24 16:21:57:504 CST] NettyClientWorker-1-1 INFO netty4.NettyClientHandler: [DUBBO] The connection of /172.19.30.91:50188 -> /172.19.30.91:20880 is established., dubbo version: , current host: 172.19.30.91

[26/12/24 16:21:57:634 CST] main INFO config.ReferenceConfig: [DUBBO] Refer dubbo service org.apache.dubbo.demo.DemoService from url zookeeper://127.0.0.1:2181/org.apache.dubbo.registry.RegistryService?anyhost=true&application=demo-consumer&check=false&default=true&deprecated=false&dubbo=2.0.2&dynamic=true&generic=false&init=false&interface=org.apache.dubbo.demo.DemoService&methods=sayHello,sayHelloAsync&pid=21624&qos.port=33333®ister.ip=172.19.30.91&release=&remote.application=demo-provider&side=consumer&sticky=false×tamp=1735201316676, dubbo version: , current host: 172.19.30.91

result: Hello world, response from provider: 172.19.30.91:20880

[26/12/24 16:21:58:196 CST] DubboShutdownHook INFO config.DubboShutdownHook: [DUBBO] Run shutdown hook now., dubbo version: , current host: 172.19.30.91

Provier 启动常见问题:

(1)Can't create adaptive extension interface org.apache.dubbo.rpc.Protocol

解决方案:JDK 版本兼容问题(JDK17运行报错,调整为JDK1.8版本)

Exception in thread "main" org.springframework.beans.factory.BeanCreationException: Error creating bean with name 'org.apache.dubbo.demo.DemoService': Instantiation of bean failed; nested exception is java.lang.ExceptionInInitializerError

at org.springframework.beans.factory.support.AbstractAutowireCapableBeanFactory.instantiateBean(AbstractAutowireCapableBeanFactory.java:1159)

.........

Caused by: java.lang.IllegalStateException: Failed to create adaptive instance: java.lang.IllegalStateException: Can't create adaptive extension interface org.apache.dubbo.rpc.Protocol, cause: Unable to make protected final java.lang.Class java.lang.ClassLoader.defineClass(java.lang.String,byte[],int,int,java.security.ProtectionDomain) throws java.lang.ClassFormatError accessible: module java.base does not "opens java.lang" to unnamed module @61322f9d

at org.apache.dubbo.common.extension.ExtensionLoader.getAdaptiveExtension(ExtensionLoader.java:605)

at org.apache.dubbo.config.ServiceConfig.<clinit>(ServiceConfig.java:118)

... 21 more

(2)zookeeper not connected

解决方案:确认Zookeeper是否正常启动,是否因连接超时导致的错误

Exception in thread "main" java.lang.IllegalStateException: zookeeper not connected

at org.apache.dubbo.remoting.zookeeper.curator.CuratorZookeeperClient.<init>(CuratorZookeeperClient.java:91)

at org.apache.dubbo.remoting.zookeeper.curator.CuratorZookeeperTransporter.createZookeeperClient(CuratorZookeeperTransporter.java:27)

at org.apache.dubbo.remoting.zookeeper.support.AbstractZookeeperTransporter.connect(AbstractZookeeperTransporter.java:70)

at org.apache.dubbo.remoting.zookeeper.ZookeeperTransporter$Adaptive.connect(ZookeeperTransporter$Adaptive.java)

(3)No application config found

解决方案:在sring配置文件(dubbo-provider.xml)中配置<dubbo:application name="demo-provider"/>

Exception in thread "main" java.lang.IllegalStateException: No application config found or it's not a valid config! Please add <dubbo:application name="..." /> to your spring config.

at org.apache.dubbo.config.utils.ConfigValidationUtils.validateApplicationConfig(ConfigValidationUtils.java:371)

at org.apache.dubbo.config.bootstrap.DubboBootstrap.checkGlobalConfigs(DubboBootstrap.java:528)

at org.apache.dubbo.config.bootstrap.DubboBootstrap.initialize(DubboBootstrap.java:515)

at org.apache.dubbo.config.bootstrap.DubboBootstrap.start(DubboBootstrap.java:744)

Consumer 启动常见问题

(1)Service invoke 失败

Exception in thread "main" org.apache.dubbo.rpc.RpcException: Failed to invoke service */org.apache.dubbo.demo.DemoService: org.apache.dubbo.remoting.RemotingException: org.apache.dubbo.remoting.RemotingException: Not found exported service: */org.apache.dubbo.demo.DemoService:20880 in [org.apache.dubbo.demo.DemoService:20880], may be version or group mismatch , channel: consumer: /172.19.30.91:49387 --> provider: /172.19.30.91:20880, message:RpcInvocation [methodName=sayHello, parameterTypes=[class java.lang.String], arguments=[], attachments={input=281, path=org.apache.dubbo.demo.DemoService, async=true, remote.application=demo-consumer, application=demo-consumer, dubbo=2.0.2, id=0, interface=org.apache.dubbo.demo.DemoService, version=0.0.0, group=*}]

org.apache.dubbo.remoting.RemotingException: Not found exported service: */org.apache.dubbo.demo.DemoService:20880 in [org.apache.dubbo.demo.DemoService:20880], may be version or group mismatch , channel: consumer: /172.19.30.91:49387 --> provider: /172.19.30.91:20880, message:RpcInvocation [methodName=sayHello, parameterTypes=[class java.lang.String], arguments=[], attachments={input=281, path=org.apache.dubbo.demo.DemoService, async=true, remote.application=demo-consumer, application=demo-consumer, dubbo=2.0.2, id=0, interface=org.apache.dubbo.demo.DemoService, version=0.0.0, group=*}]

at org.apache.dubbo.rpc.protocol.dubbo.DubboProtocol.getInvoker(DubboProtocol.java:271)

确认对应接口是否存在于注册中心,检查消费方配置<dubbo:reference id="demoService" check="false" interface="org.apache.dubbo.demo.DemoService"/>

如果接口提供方没有指定group,对于消费方则不需要指定group定位接口服务,否则可能导致分组检索时找不到已经发布的服务接口

② 基于注解配置dubbo-demo-annotation

- Provider:基于注解配置概念,将自定义的服务发布发布出去(

@EnableDubbo) - Consumer:基于注解配置概念,引入服务接口(

@Reference)

dubbo-demo-provider

- ① 通过注解配置ProviderConfiguration, Application启动基于该配置初始化加载

public class Application {

public static void main(String[] args) throws Exception {

// 使用AnnotationConfigApplicationContext初始化Spring容器,从ProviderConfiguration这个类的注解上拿相关配置

AnnotationConfigApplicationContext context = new AnnotationConfigApplicationContext(ProviderConfiguration.class);

context.start();

System.in.read();

}

@Configuration // 配置类

@EnableDubbo(scanBasePackages = "org.apache.dubbo.demo.provider") // @EnableDubbo注解指定包下的Bean都会被扫描,并作为Dubbo服务暴露出去

@PropertySource("classpath:/spring/dubbo-provider.properties") // @PropertySource指定配置信息

static class ProviderConfiguration {

@Bean

public RegistryConfig registryConfig() {

RegistryConfig registryConfig = new RegistryConfig();

registryConfig.setAddress("zookeeper://127.0.0.1:2181");

return registryConfig;

}

}

}

- ②

spring/dubbo-provider.proterites配置dubbo基础配置

dubbo.application.name=dubbo-demo-annotation-provider

dubbo.protocol.name=dubbo

dubbo.protocol.port=20880

dubbo-demo-consumer

- ① 配置服务发现组件,填充业务逻辑(调用服务接口)(

DemoServiceComponent)

@Component("demoServiceComponent")

public class DemoServiceComponent implements DemoService {

@Reference // 注入dubbo服务

private DemoService demoService;

@Override

public String sayHello(String name) {

return demoService.sayHello(name);

}

@Override

public CompletableFuture<String> sayHelloAsync(String name) {

return null;

}

}

- ②

Application启动类配置,启动消费者

public class Application {

/**

* In order to make sure multicast registry works, need to specify '-Djava.net.preferIPv4Stack=true' before

* launch the application

*/

public static void main(String[] args) {

// 加载ConsumerConfiguration配置,启动服务

AnnotationConfigApplicationContext context = new AnnotationConfigApplicationContext(ConsumerConfiguration.class);

context.start();

// 测试服务接口调用逻辑

DemoService service = context.getBean("demoServiceComponent", DemoServiceComponent.class);

String hello = service.sayHello("world");

System.out.println("result :" + hello);

}

@Configuration

@EnableDubbo(scanBasePackages = "org.apache.dubbo.demo.consumer.comp")

@PropertySource("classpath:/spring/dubbo-consumer.properties")

@ComponentScan(value = {"org.apache.dubbo.demo.consumer.comp"})

static class ConsumerConfiguration {

}

}

- ③

spring/dubbo-consumer.proterites配置dubbo基础配置

dubbo.application.name=dubbo-demo-annotation-consumer

dubbo.registry.address=zookeeper://127.0.0.1:2181

启动测试(先Provider后Consumer)

- ① Provider 启动测试

[26/12/24 16:52:25:517 CST] main INFO metadata.DynamicConfigurationServiceNameMapping: [DUBBO] Dubbo service[null] mapped to interface name[org.apache.dubbo.demo.DemoService]., dubbo version: , current host: 172.19.30.91

[26/12/24 16:52:25:522 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap is ready., dubbo version: , current host: 172.19.30.91

[26/12/24 16:52:25:522 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap has started., dubbo version: , current host: 172.19.30.91

- ② Consumer 启动测试

[26/12/24 16:53:42:932 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap is ready., dubbo version: , current host: 172.19.30.91

[26/12/24 16:53:42:932 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap has started., dubbo version: , current host: 172.19.30.91

result :Hello world, response from provider: 172.19.30.91:20880

[26/12/24 16:53:43:236 CST] DubboShutdownHook INFO config.DubboShutdownHook: [DUBBO] Run shutdown hook now., dubbo version: , current host: 172.19.30.91

[26/12/24 16:53:43:237 CST] Thread-0 INFO annotation.AnnotationConfigApplicationContext: Closing org.springframework.context.annotation.AnnotationConfigApplicationContext@610694f1: startup date [Thu Dec 26 16:53:41 CST 2024]; root of context hierarchy

③ 基于API配置dubbo-demo-api

在一些场景中并没有依赖Spring模块,因此没有办法通过上述xml和annotation方式接入dubbo(构建Dubbo Provider和Dubbo Consumer),比较典型的一种场景就是构建SDK的时候

dubbo-demo-api-provider

ServiceConfig配置

public class Application {

public static void main(String[] args) throws Exception {

if (isClassic(args)) {

startWithExport();

} else {

startWithBootstrap();

}

}

private static boolean isClassic(String[] args) {

return args.length > 0 && "classic".equalsIgnoreCase(args[0]);

}

private static void startWithBootstrap() {

// ServiceConfig 配置 服务接口

ServiceConfig<DemoServiceImpl> service = new ServiceConfig<>();

service.setInterface(DemoService.class);

service.setRef(new DemoServiceImpl());

// 基于DubboBootstrap启动:生成ApplicationConfig实例、指定ZK地址以及ServiceConfig实例

DubboBootstrap bootstrap = DubboBootstrap.getInstance();

bootstrap.application(new ApplicationConfig("dubbo-demo-api-provider"))

.registry(new RegistryConfig("zookeeper://127.0.0.1:2181"))

.service(service)

.start()

.await();

}

private static void startWithExport() throws InterruptedException {

// ServiceConfig 配置 服务接口、注册中心配置、暴露服务

ServiceConfig<DemoServiceImpl> service = new ServiceConfig<>();

service.setInterface(DemoService.class);

service.setRef(new DemoServiceImpl());

service.setApplication(new ApplicationConfig("dubbo-demo-api-provider"));

service.setRegistry(new RegistryConfig("zookeeper://127.0.0.1:2181"));

service.export();

System.out.println("dubbo service started");

new CountDownLatch(1).await();

}

}

dubbo-demo-api-consumer

public class Application {

public static void main(String[] args) {

if (isClassic(args)) {

runWithRefer();

} else {

runWithBootstrap();

}

}

private static boolean isClassic(String[] args) {

return args.length > 0 && "classic".equalsIgnoreCase(args[0]);

}

private static void runWithBootstrap() {

ReferenceConfig<DemoService> reference = new ReferenceConfig<>();

reference.setInterface(DemoService.class);

reference.setGeneric("true");

DubboBootstrap bootstrap = DubboBootstrap.getInstance();

bootstrap.application(new ApplicationConfig("dubbo-demo-api-consumer"))

.registry(new RegistryConfig("zookeeper://127.0.0.1:2181"))

.reference(reference)

.start();

DemoService demoService = ReferenceConfigCache.getCache().get(reference);

String message = demoService.sayHello("dubbo");

System.out.println(message);

// generic invoke

GenericService genericService = (GenericService) demoService;

Object genericInvokeResult = genericService.$invoke("sayHello", new String[] { String.class.getName() },

new Object[] { "dubbo generic invoke" });

System.out.println(genericInvokeResult);

}

private static void runWithRefer() {

ReferenceConfig<DemoService> reference = new ReferenceConfig<>();

reference.setApplication(new ApplicationConfig("dubbo-demo-api-consumer"));

reference.setRegistry(new RegistryConfig("zookeeper://127.0.0.1:2181"));

reference.setInterface(DemoService.class);

DemoService service = reference.get();

String message = service.sayHello("dubbo");

System.out.println(message);

}

}

启动测试(先Provider后Consumer)

- Provider

[26/12/24 17:22:53:054 CST] main INFO migration.MigrationRuleListener: [DUBBO] INIT, dubbo version: , current host: 172.19.30.91

[26/12/24 17:22:53:152 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap is ready., dubbo version: , current host: 172.19.30.91

[26/12/24 17:22:53:154 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap has started., dubbo version: , current host: 172.19.30.91

[26/12/24 17:22:53:154 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap awaiting ..., dubbo version: , current host: 172.19.30.91

- Consumer

[26/12/24 17:23:15:610 CST] main INFO config.ReferenceConfig: [DUBBO] Refer dubbo service org.apache.dubbo.rpc.service.GenericService from url dubbo://172.19.30.91/org.apache.dubbo.demo.DemoService?anyhost=true&application=dubbo-demo-api-consumer&check=false&default=true&deprecated=false&dubbo=2.0.2&dynamic=true&generic=true&interface=org.apache.dubbo.demo.DemoService&methods=sayHello,sayHelloAsync&pid=9624®ister.ip=172.19.30.91&release=release&remote.application=dubbo-demo-api-provider&service.name=ServiceBean:/org.apache.dubbo.demo.DemoService&side=consumer&sticky=false×tamp=1735204995024, dubbo version: , current host: 172.19.30.91

[26/12/24 17:23:15:623 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap is ready., dubbo version: , current host: 172.19.30.91

[26/12/24 17:23:15:625 CST] main INFO bootstrap.DubboBootstrap: [DUBBO] DubboBootstrap has started., dubbo version: , current host: 172.19.30.91

Hello dubbo, response from provider: 172.19.30.91:20880

Hello dubbo generic invoke, response from provider: 172.19.30.91:20880

[26/12/24 17:23:15:864 CST] DubboShutdownHook INFO config.DubboShutdownHook: [DUBBO] Run shutdown hook now., dubbo version: , current host: 172.19.30.91

② dubbo 的配置总线

学习目标

- dubbo url 核心解读 及 应用

- URL:dubbo的配置总线,在dubbo的设计场景中起到核心作用,其结构简单清晰易处理,在上下文传递和参数处理过程中非常适用,简化开发沟通成本

- URL在 dubbo 的场景设计应用:

SPI扩展类接口设计应用、服务发现设计应用(服务暴露、服务订阅等通过URL给注册中心传递关键信息)

1.URL(dubbo 的配置总线)

在互联网领域,每个信息资源都有统一的且在网上唯一的地址,该地址就叫 URL(Uniform Resource Locator,统一资源定位符),它是互联网的统一资源定位标志,也就是指网络地址。URL 本质上就是一个特殊格式的字符串。一个标准的 URL 格式可以包含如下的几个部分:

protocol://username:password@host:port/path?key=value&key=value

- protocol:URL 的协议。常见的就是 HTTP 协议和 HTTPS 协议。还有其他协议,如 FTP 协议、SMTP 协议等

- username/password:用户名/密码。 HTTP Basic Authentication 中多会使用在 URL 的协议之后直接携带用户名和密码的方式

- host/port:主机/端口。在实践中一般会使用域名,而不是使用具体的 host 和 port

- path:请求的路径

- parameters:参数键值对。一般在 GET 请求中会将参数放到 URL 中,POST 请求会将参数放到请求体中

URL 是整个 Dubbo 中非常基础,也是非常核心的一个组件,阅读源码的过程中会发现很多方法都是以 URL 作为参数的,在方法内部解析传入的 URL 得到有用的参数,所以有人将 URL 称为Dubbo 的配置总线。

例如在 Dubbo SPI 核心实现中, URL 参与了扩展实现的确定;

例如在注册中心实现中,Provider 将自身的信息封装成 URL 注册到 ZooKeeper 中,从而暴露自己的服务, Consumer 也是通过 URL 来确定自己订阅了哪些 Provider 的

由此可见,URL 之于 Dubbo 是非常重要的,所以说“抓住 URL,就理解了半个 Dubbo”

2.Dubbo 中 的 URL

Dubbo 中任意的一个实现都可以抽象为一个 URL,Dubbo 使用 URL 来统一描述了所有对象和配置信息,并贯穿在整个 Dubbo 框架之中。可以来看 Dubbo 中一个典型 URL 的示例,如下(可以从服务的日志中得到URL信息):

dubbo://172.17.32.91:20880/org.apache.dubbo.demo.DemoService?anyhost=true&application=dubbo-demo-api-provider&dubbo=2.0.2&interface=org.apache.dubbo.demo.DemoService&methods=sayHello,sayHelloAsync&pid=32508&release=&side=provider×tamp=1593253404714dubbo://172.17.32.91:20880/org.apache.dubbo.demo.DemoService?anyhost=true&application=dubbo-demo-api-provider&dubbo=2.0.2&interface=org.apache.dubbo.demo.DemoService&methods=sayHello,sayHelloAsync&pid=32508&release=&side=provider×tamp=1593253404714

这个 Demo Provider 注册到 ZooKeeper 上的 URL 信息,简单解析一下这个 URL 的各个部分:

- protocol:dubbo 协议。

- username/password:没有用户名和密码。

- host/port:172.17.32.91:20880。

- path:org.apache.dubbo.demo.DemoService。

- parameters:参数键值对,这里是问号后面的参数。

下面是 URL 的构造方法,可以看到其核心字段与前文分析的 URL 基本一致:

public URL(String protocol,

String username,

String password,

String host,

int port,

String path,

Map<String, String> parameters,

Map<String, Map<String, String>> methodParameters) {

if (StringUtils.isEmpty(username)

&& StringUtils.isNotEmpty(password)) {

throw new IllegalArgumentException("Invalid url");

}

this.protocol = protocol;

this.username = username;

this.password = password;

this.host = host;

this.port = Math.max(port, 0);

this.address = getAddress(this.host, this.port);

while (path != null && path.startsWith("/")) {

path = path.substring(1);

}

this.path = path;

if (parameters == null) {

parameters = new HashMap<>();

} else {

parameters = new HashMap<>(parameters);

}

this.parameters = Collections.unmodifiableMap(parameters);

this.methodParameters = Collections.unmodifiableMap(methodParameters);

}

另外,在 dubbo-common 包中还提供了 URL 的辅助类:

- URLBuilder, 辅助构造 URL;

- URLStrParser, 将字符串解析成 URL 对象

契约的力量

对于 Dubbo 中的 URL,很多人称之为“配置总线”,也有人称之为“统一配置模型”。虽然说法不同,但都是在表达一个意思,URL 在 Dubbo 中被当作是“公共的契约”。一个 URL 可以包含非常多的扩展点参数,URL 作为上下文信息贯穿整个扩展点设计体系。

其实,一个优秀的开源产品都有一套灵活清晰的扩展契约,不仅是第三方可以按照这个契约进行扩展,其自身的内核也可以按照这个契约进行搭建。如果没有一个公共的契约,只是针对每个接口或方法进行约定,就会导致不同的接口甚至同一接口中的不同方法,以不同的参数类型进行传参,一会儿传递 Map,一会儿传递字符串,而且字符串的格式也不确定,需要自己进行解析,这就多了一层没有明确表现出来的隐含的约定。

所以说,在 Dubbo 中使用 URL 的好处多多,增加了便捷性:

- ① 上下文信息传递:代码更加易读、易懂,不用花大量时间去揣测传递数据的格式和含义,进而形成一个统一的规范,使得代码易写、易读

- ② 方法入参:使用 URL 作为方法的入参(相当于一个

Map<String,String>),它所表达的含义比单个参数更丰富,当代码需要扩展的时候,可以将新的参数以 Key/Value 的形式追加到 URL 之中,而不需要改变入参或是返回值的结构 - ③ 简化沟通:使用 URL 这种“公共的契约”可以简化沟通,人与人之间的沟通消耗是非常大的,信息传递的效率非常低,使用统一的契约、术语、词汇范围,可以省去很多沟通成本,尽可能地提高沟通效率

3.Dubbo中的URL示例

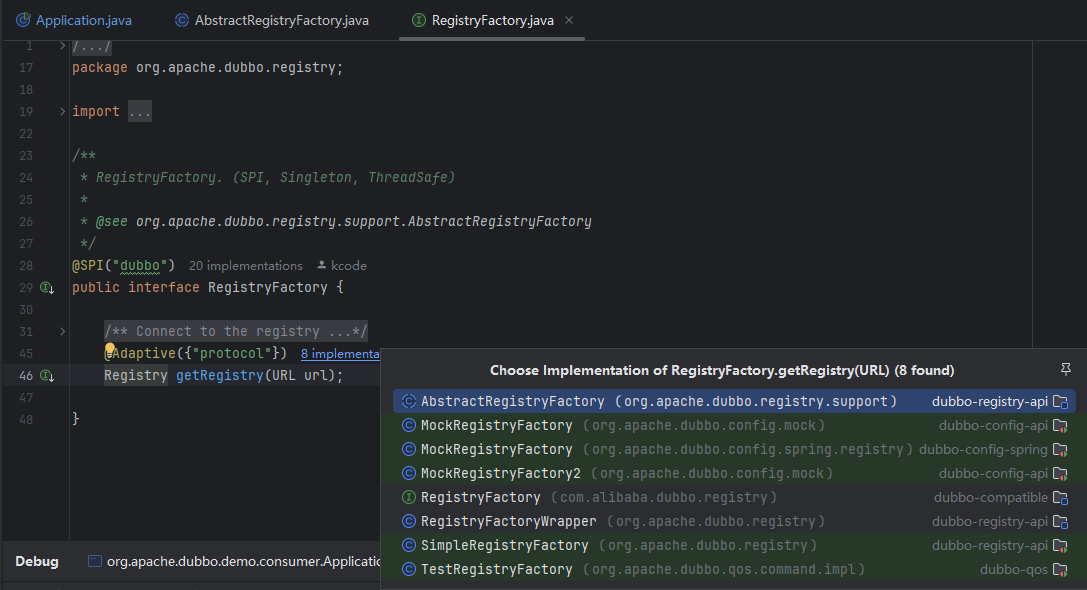

① URL 在 SPI 中的应用

Dubbo SPI 中有一个依赖 URL 的重要场景——适配器方法,是被 @Adaptive 注解标注的, URL 一个很重要的作用就是与 @Adaptive 注解一起选择合适的扩展实现类。

例如,在 dubbo-registry-api 模块中的 RegistryFactory这个接口,其中的 getRegistry() 方法上有@Adaptive({"protocol"})注解,说明这是一个适配器方法,Dubbo 在运行时会为其动态生成相应的 $Adaptive 类型,如下所示:

/**

* RegistryFactory. (SPI, Singleton, ThreadSafe)

*

* @see org.apache.dubbo.registry.support.AbstractRegistryFactory

*/

@SPI("dubbo")

public interface RegistryFactory {

/**

* Connect to the registry

* <p>

* Connecting the registry needs to support the contract: <br>

* 1. When the check=false is set, the connection is not checked, otherwise the exception is thrown when disconnection <br>

* 2. Support username:password authority authentication on URL.<br>

* 3. Support the backup=10.20.153.10 candidate registry cluster address.<br>

* 4. Support file=registry.cache local disk file cache.<br>

* 5. Support the timeout=1000 request timeout setting.<br>

* 6. Support session=60000 session timeout or expiration settings.<br>

*

* @param url Registry address, is not allowed to be empty

* @return Registry reference, never return empty value

*/

@Adaptive({"protocol"})

Registry getRegistry(URL url);

}

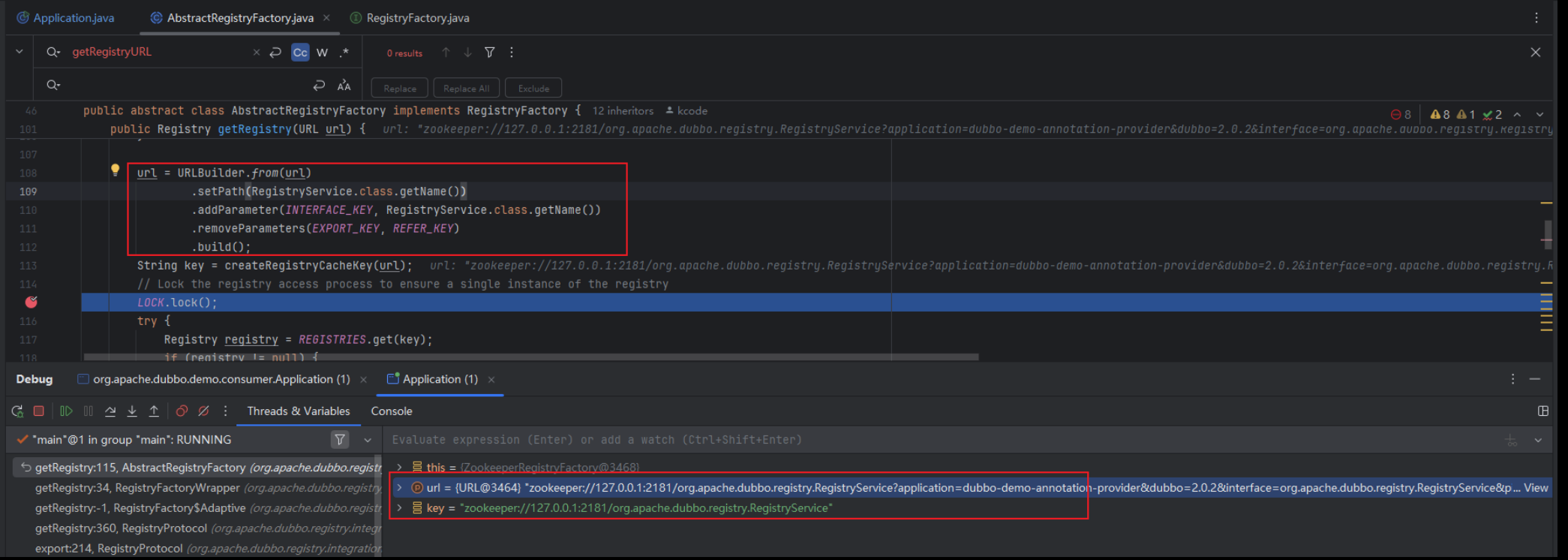

启动dubbo-demo中的任意一个demo的Provider服务,然后在getRegistry方法中打断点查看断点信息(不同版本源码对注册中心配置的实现有所不同,此处结合源码提示分析不同的实现:关注AbstractRegistryFactory#getRegistry的方法实现,设置断点,启动Provider服务随后查看断点配置信息)

根据上述断点调试的URL可以跟踪到设置的注册中心参数配置信息

zookeeper://127.0.0.1:2181/org.apache.dubbo.registry.RegistryService?application=dubbo-demo-annotation-provider&dubbo=2.0.2&interface=org.apache.dubbo.registry.RegistryService&pid=19584×tamp=1735278180154

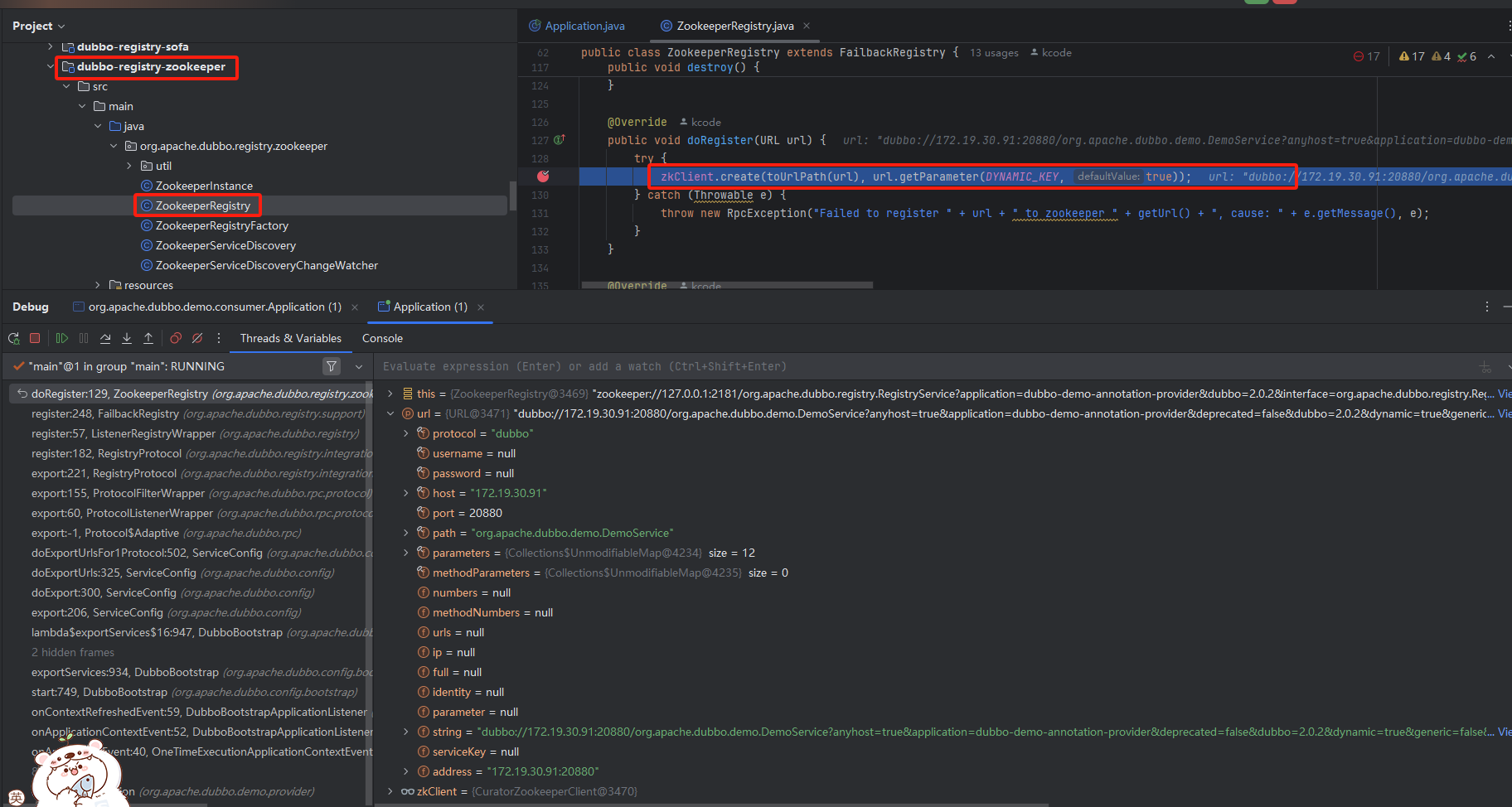

② URL 在服务暴露中的应用

在介绍 Dubbo 的简化架构时提到,Provider 在启动时,会将自身暴露的服务注册到 ZooKeeper 上,此处也可通过断掉调试看具体是注册哪些信息到 ZooKeeper上

此处使用的是zookeeper注册中心,因此可以通过跟踪dubbo-registry-zookeeper中的相关实现方法,定位ZookeeperRegistry#doRegistry(服务暴露方法核心)

根据注册的URL,查看基于服务暴露传递给注册中心的参数信息

- 服务方接口地址:

172.19.30.91:20880 - 暴露服务接口等信息:

org.apache.dubbo.demo.DemoService

dubbo://172.19.30.91:20880/org.apache.dubbo.demo.DemoService?anyhost=true&application=dubbo-demo-annotation-provider&deprecated=false&dubbo=2.0.2&dynamic=true&generic=false&interface=org.apache.dubbo.demo.DemoService&methods=sayHello,sayHelloAsync&pid=9476&release=&side=provider×tamp=1735278886583

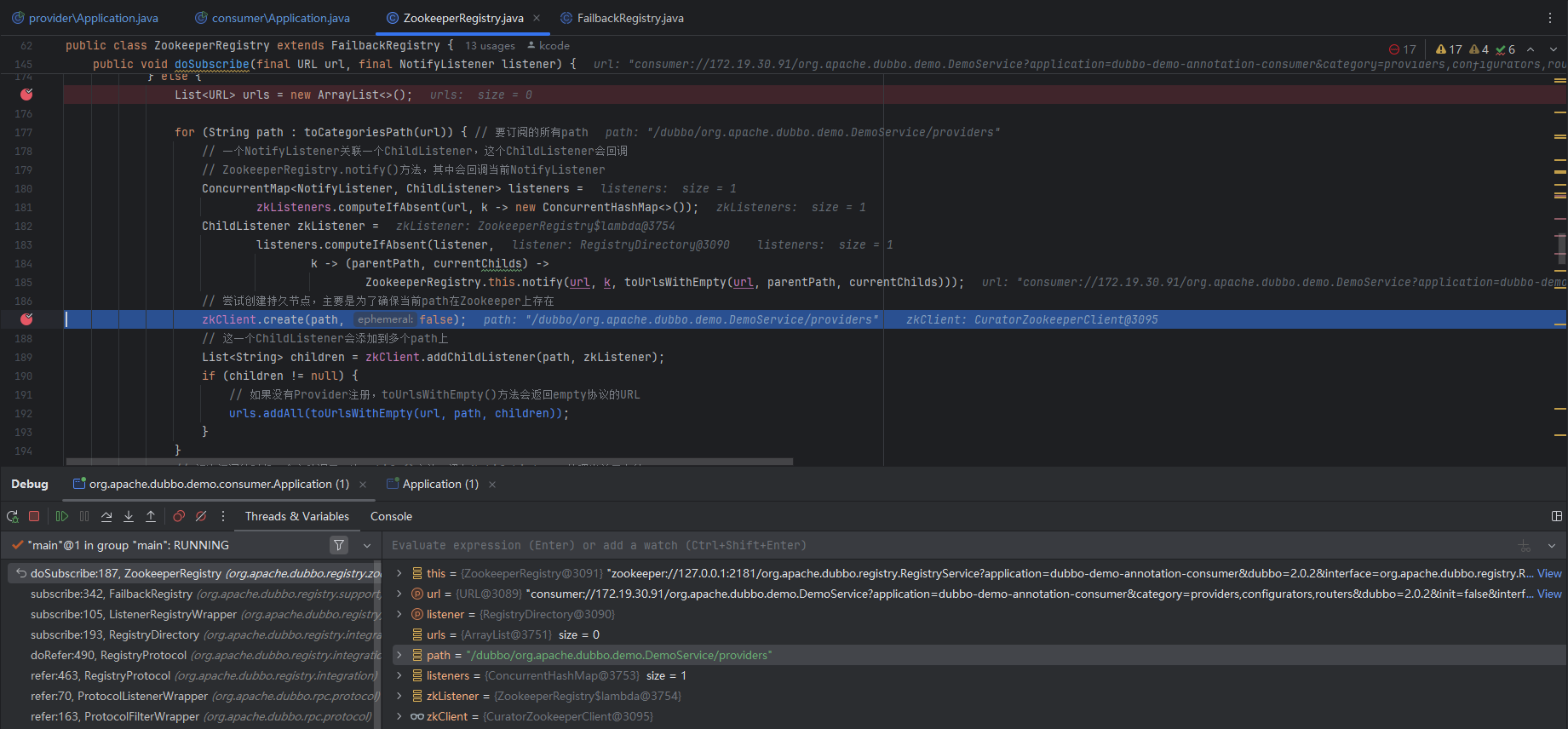

③ URL 在服务订阅中的应用

同理,服务提供方启动后会将指定的服务接口注册到注册中心,而服务消费方启动后也会向注册中心发起订阅操作,监听并关注自己的Provider,那Consumer是如何告诉注册中心自己关注哪些 Provider 呢?

此处使用的注册中心是zookeeper,因此继续关注ZookeeperRegistry#doSubscribe方法(服务订阅方法核心),启动Consumer端并通过断点调试。通过断掉调试可以看到服务订阅的相关URL

consumer://172.19.30.91/org.apache.dubbo.demo.DemoService?application=dubbo-demo-annotation-consumer&category=providers,configurators,routers&dubbo=2.0.2&init=false&interface=org.apache.dubbo.demo.DemoService&methods=sayHello,sayHelloAsync&pid=17536&side=consumer&sticky=false×tamp=1735279582654

Consumer 订阅信息解读:

- ① Protocol 为 consumer:表示是 Consumer 的订阅协议

- ② category 参数表示要订阅的分类(这里要订阅 providers、configurators 以及 routers 三个分类)

- ③ interface 参数表示订阅哪个服务接口,这里要订阅的是暴露 org.apache.dubbo.demo.DemoService 实现的 Provider

通过 URL 中的上述参数,ZookeeperRegistry 会在 toCategoriesPath() 方法中将其整理成一个 ZooKeeper 路径,然后调用 zkClient 在其上添加监听。

③ dubbo SPI 剖析

学习目标

- SPI 机制概念核心

- Dubbo 中的 SPI 机制剖析

- ① SPI 配置文件扩展:目录扩展(引入多目录接口存储不同用途的SPI配置文件)、格式扩展(KV格式存储)

- ② @SPI :扩展接口标记,关注

ExtensionLoader(对标ServiceLoader)装配逻辑 - ③ @Adaptive 注解与适配器

- ④ 自动包装特性:Wrapper 概念(装饰类模式构建,封装基础代码)

- ⑤ 自动装配特性:自动装配属性就是在加载一个扩展点的时候,将其依赖的扩展点一并加载,并进行装配

- ⑥ @Activate 注解与自动激活特性:自动激活配置,用于协同多个分组下的类应用(例如用于指定一个场景中多个Filter的情况下哪些Filter是可用的)

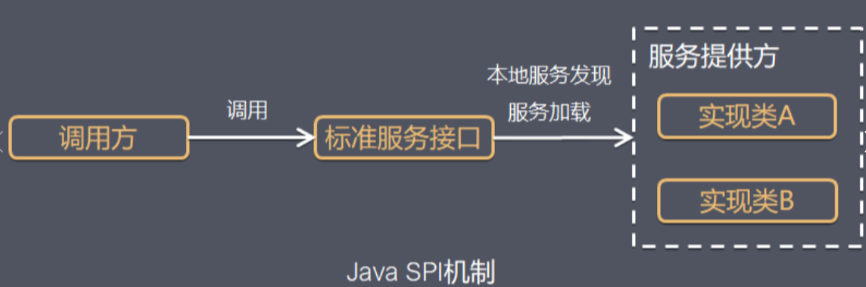

1.什么是SPI?

⚽ JDK SPI

(1)SPI 基本概念

SPI(Service Provider Interface)服务提供接口主要是被框架开发人员使用的一种技术。

例如,使用 Java 语言访问数据库时我们会使用到 java.sql.Driver 接口,不同数据库产品底层的协议不同,提供的 java.sql.Driver 实现也不同,在开发 java.sql.Driver 接口时,开发人员并不清楚用户最终会使用哪个数据库,在这种情况下就可以使用 Java SPI 机制在实际运行过程中,为 java.sql.Driver 接口寻找具体的实现。

SPI全称Service Provider Interface(提供服务的接口,动态加载服务的机制),Java提供的一套用来被第三方实现或扩展的接口,实现了接口的动态扩展,让第三方的实现类能像插件一样嵌入到系统中。

其主要思想:将装配的控制权限移到程序之外(解耦)

其本质构建在于将接口的实现类的全限定名配置在文件中(文件名是接口的全限定名),由服务加载器读取配置文件,加载实现类。实现了运行时动态为接口替换实现类

SPI核心要素

- SPI 接口:为服务提供者实现类约定的的接口或抽象类

- SPI 实现类:实际提供服务的实现类

- SPI 配置:Java SPI 机制约定的配置文件,提供查找服务实现类的逻辑。配置文件必须置于

META-INF/services目录中,并且,文件名应与服务提供者接口的完全限定名保持一致。文件中的每一行都有一个实现服务类的详细信息,同样是服务提供者类的完全限定名称 - ServiceLoader:Java SPI 的核心类,用于加载 SPI 实现类。

ServiceLoader中有各种实用方法来获取特定实现、迭代它们或重新加载服务

SPI 场景应用

除却一些业务开发场景扩展分析,还有一些框架场景也会用到SPI机制,例如最常见的就是JDBC数据库加载、LOG日志,此外SpringBoot、Dubbo等框架中也对SPI机制有着不同的实现和扩展

传统的基于JDK的SPI机制虽然简单,但是也具备局限性。例如其无法支持按需加载(需全量扫描迭代所有接口服务),且存在并发安全问题(在并发场景下如果多个并发多线程同时使用ServiceLoader类是不安全的)

(2)SPI 简单demo示例(自定义MyLog)

① 基础准备(接口和接口服务实现定义)

- 定义

MyLog接口 - 定义

ConsoleLog、WebLog分别实现MyLog接口

/**

* 自定义日志接口

*/

public interface MyLog {

public void info(String str);

}

// ConsoleLog

public class ConsoleLog implements MyLog {

@Override

public void info(String str) {

System.out.println("console log out:" + str);

}

}

// WebLog

public class WebLog implements MyLog {

@Override

public void info(String str) {

System.out.println("web log out:" + str);

}

}

② 传统接口定义和使用

- 定义接口实现,直接通过引用类的方式实现服务

// ① 传统方式引用服务

public static void testCase1() {

ConsoleLog consoleLog = new ConsoleLog();

consoleLog.info("hhh");

WebLog webLog = new WebLog();

webLog.info("xxx");

}

③ SPI 方式接入

- 在

resources/services/下创建文件(文件名称为接口的全限定类名),内容为接口服务实现类(实现类的全限定类名)

# com.noob.rpc.spi.MyLog 文件

com.noob.rpc.spi.impl.ConsoleLog

com.noob.rpc.spi.impl.WebLog

- 通过

ServiceLoader和iterator迭代器遍历接口实现,调用相应的方法

// ② SPI方式引用服务

public static void testCase2() {

// 使用ServiceLoader动态加载指定接口的实现类

ServiceLoader<MyLog> serviceLoader = ServiceLoader.load(MyLog.class);

// 借助迭代器获取实现类信息

Iterator<MyLog> iterator = serviceLoader.iterator();

while (iterator.hasNext()) {

MyLog myLog = iterator.next();

myLog.info("keep...");

}

}

2.Dubbo中的SPI?

⚽Dubbo 中的SPI

Dubbo 为了更好地达到 OCP 原则(即“对扩展开放,对修改封闭”的原则),采用了“微内核+插件”的架构。那什么是微内核架构呢?微内核架构也被称为插件化架构(Plug-in Architecture),这是一种面向功能进行拆分的可扩展性架构。内核功能是比较稳定的,只负责管理插件的生命周期,不会因为系统功能的扩展而不断进行修改。功能上的扩展全部封装到插件之中,插件模块是独立存在的模块,包含特定的功能,能拓展内核系统的功能。

微内核架构中,内核通常采用 Factory、IOC、OSGi 等方式管理插件生命周期,Dubbo 最终决定采用 SPI 机制来加载插件,Dubbo SPI 参考 JDK 原生的 SPI 机制,进行了性能优化以及功能增强。

扩展点 & 扩展实现

- 扩展点:扩展接口定义,通过 SPI 机制查找并加载实现的接口(又称“扩展接口”)。例如场景案例中的

Log接口、com.mysql.cj.jdbc.Driver接口,都是扩展点 - 扩展实现:实现了扩展接口的实现类

Dubbo 中的SPI机制

通过前面的分析可以知道JDK SPI机制无法支持按需加载,也就是说JDK SPI 在查找扩展实现类的过程中,需要遍历 SPI 配置文件中定义的所有实现类,该过程中会将这些实现类全部实例化。如果 SPI 配置文件中定义了多个实现类,而实际只需要使用其中一个实现类时,就会生成不必要的对象。

例如,org.apache.dubbo.rpc.Protocol 接口有 InjvmProtocol、DubboProtocol、RmiProtocol、HttpProtocol、HessianProtocol、ThriftProtocol 等多个实现,如果使用 JDK SPI,就会加载全部实现类,导致资源的浪费。

Dubbo SPI 不仅解决了上述资源浪费的问题,还对 SPI 配置文件扩展和修改。

⚽Dubbo 中的SPI核心实现

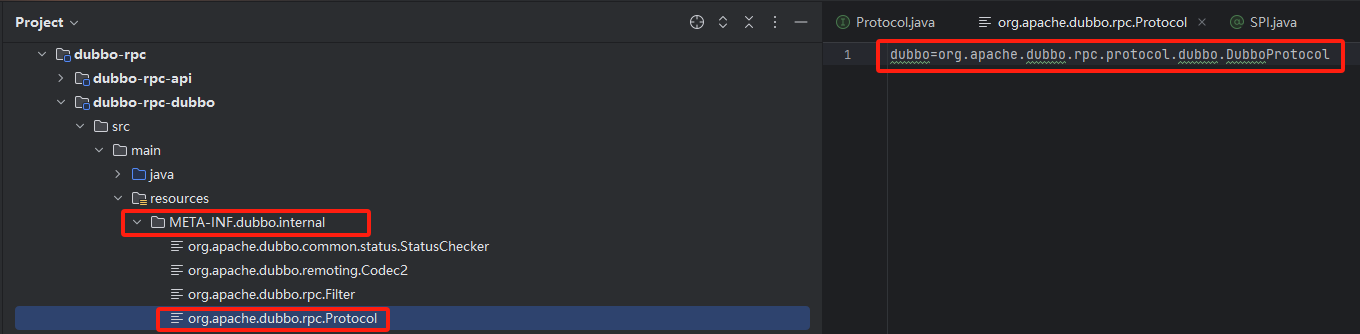

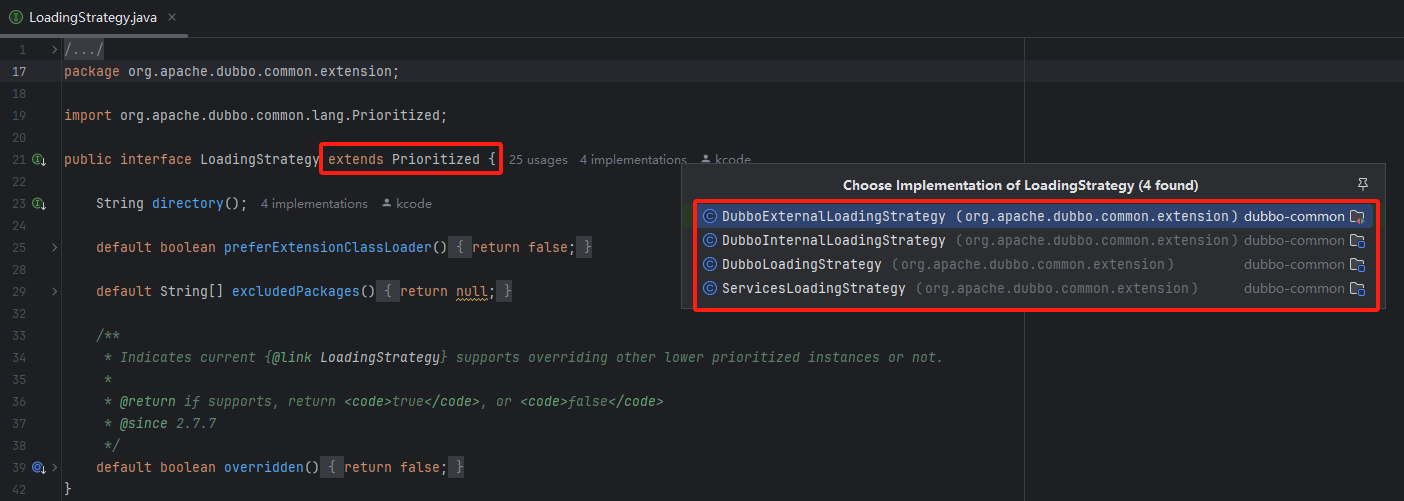

① SPI配置文件扩展

Dubbo 将 SPI 配置文件按照不同的用途划分为三类目录:

- (1)

META-INF/services/目录:该目录下的 SPI 配置文件用来兼容 JDK SPI - (2)

META-INF/dubbo/目录:该目录用于存放用户自定义 SPI 配置文件 - (3)

META-INF/dubbo/internal/目录:该目录用于存放 Dubbo 内部使用的 SPI 配置文件

并将配置文件的格式改成了KV格式,例如dubbo=org.apache.dubbo.rpc.protocol.dubbo.DubboProtocol。此处的key被称为扩展名(ExtensionName),当要为一个接口查找具体实现类时可以通过指定扩展名来选择相应的扩展实现。

例如以上述的MyLog案例中,如果基于JDK SPI机制,由于无法实现按需加载,因此当要使用某个具体的扩展类实现时,就需要遍历全量的实现类列表。如果基于这种KV形式,则可以通过配置consoleLog=com.noob.rpc.spi.impl.ConsoleLog、webLog=com.noob.rpc.spi.impl.WebLog,那么在应用中就可以通过指定扩展名指定要加载的扩展实现类,避免全量加载,解决按需加载场景问题

此外,使用KV格式的SPI配置文件的另一个好处在于更加容易定位问题。假设使用的一个扩展实现类所在的 jar 包没有引入到项目中,那么 Dubbo SPI 在抛出异常的时候,会携带该扩展名信息,而不是简单地提示扩展实现类无法加载。这些更加准确的异常信息降低了排查问题的难度,提高了排查问题的效率

② @SPI 注解

Dubbo 中某个接口被 @SPI注解修饰时,就表示该接口是扩展接口,例如 org.apache.dubbo.rpc.Protocol、org.apache.dubbo.registry.RegistryFactory 接口就是一个扩展接口

扩展接口示例

@SPI("dubbo")

public interface Protocol {

...

}

@SPI("dubbo")

public interface RegistryFactory {

@Adaptive({"protocol"})

Registry getRegistry(URL url);

}

@SPI注解

@SPI 注解的 value 值指定了默认的扩展名

例如,在通过 Dubbo SPI 加载 Protocol 接口实现时,如果没有明确指定扩展名,则默认会将 @SPI 注解的 value 值作为扩展名,即加载 dubbo 这个扩展名对应的 org.apache.dubbo.rpc.protocol.dubbo.DubboProtocol 这个扩展实现类,相关的 SPI 配置文件在 dubbo-rpc-dubbo 模块中,如下图所示:

@Documented

@Retention(RetentionPolicy.RUNTIME)

@Target({ElementType.TYPE})

public @interface SPI {

/**

* default extension name

*/

String value() default "";

}

ExtensionLoader

对标JDK SPI机制中的ServiceLoader,Dubbo提供了ExtensionLoader用于加载扩展类。参考dubbo-common模块下的org.apache.dubbo.common.extension.ExtensionLoader实现,进一步剖析ExtensionLoader是如何处理@SPI注解的

ExtensionLoader 位于 dubbo-common 模块中的 extension 包中,功能类似于 JDK SPI 中的 java.util.ServiceLoader。Dubbo SPI 的核心逻辑几乎都封装在 ExtensionLoader 之中(其中就包括 @SPI 注解的处理逻辑)其使用方式如下所示:

Protocol protocol = ExtensionLoader.getExtensionLoader(Protocol.class).getExtension("dubbo");

ExtensionLoader的核心静态字段:strategies(LoadingStrategy[]类型):有多个实现,分别用于加载上述dubbo提供的约定目录下的SPI配置文件

EXTENSION_LOADERS(ConcurrentMap<Class<?>, ExtensionLoader<?>>类型):Dubbo 中一个扩展接口对应一个 ExtensionLoader 实例,该集合缓存了全部 ExtensionLoader 实例,其中的 Key 为扩展接口,Value 为加载其扩展实现的 ExtensionLoader 实例EXTENSION_INSTANCES(ConcurrentMap<Class<?>, Object>类型):该集合缓存了扩展实现类与其实例对象的映射关系。以上述分析为例,Key 为 Class,Value 为 DubboProtocol 对象

ExtensionLoader的实例字段:- type(Class<?>类型):当前 ExtensionLoader 实例负责加载扩展接口

- cachedDefaultName(String类型):记录了 type 这个扩展接口上 @SPI 注解的 value 值,也就是默认扩展名

- cachedNames(ConcurrentMap, String>类型):缓存了该 ExtensionLoader 加载的扩展实现类与扩展名之间的映射关系

- cachedClasses(Holder>>类型):缓存了该 ExtensionLoader 加载的扩展名与扩展实现类之间的映射关系。cachedNames 集合的反向关系缓存

- cachedInstances(ConcurrentMap>类型):缓存了该 ExtensionLoader 加载的扩展名与扩展实现对象之间的映射关系

ExtensionLoader核心方法getExtensionLoader

@SuppressWarnings("unchecked")

public static <T> ExtensionLoader<T> getExtensionLoader(Class<T> type) {

if (type == null) {

throw new IllegalArgumentException("Extension type == null");

}

if (!type.isInterface()) {

throw new IllegalArgumentException("Extension type (" + type + ") is not an interface!");

}

if (!withExtensionAnnotation(type)) {

throw new IllegalArgumentException("Extension type (" + type +

") is not an extension, because it is NOT annotated with @" + SPI.class.getSimpleName() + "!");

}

ExtensionLoader<T> loader = (ExtensionLoader<T>) EXTENSION_LOADERS.get(type);

if (loader == null) {

EXTENSION_LOADERS.putIfAbsent(type, new ExtensionLoader<T>(type));

loader = (ExtensionLoader<T>) EXTENSION_LOADERS.get(type);

}

return loader;

}

得到接口对应的 ExtensionLoader 对象之后会调用其 getExtension() 方法,根据传入的扩展名称从 cachedInstances 缓存中查找扩展实现的实例,最终将其实例化后返回

@SuppressWarnings("unchecked")

public T getExtension(String name) {

if (StringUtils.isEmpty(name)) {

throw new IllegalArgumentException("Extension name == null");

}

if ("true".equals(name)) {

return getDefaultExtension();

}

// getOrCreateHolder()方法中封装了查找cachedInstances缓存的逻辑

final Holder<Object> holder = getOrCreateHolder(name);

Object instance = holder.get();

if (instance == null) { // double-check防止并发问题

synchronized (holder) {

instance = holder.get();

if (instance == null) {

// 根据扩展名从SPI配置文件中查找对应的扩展实现类

instance = createExtension(name);

holder.set(instance);

}

}

}

return (T) instance;

}

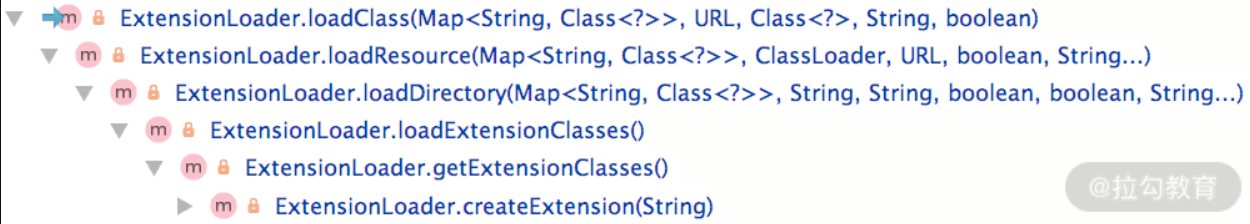

在 createExtension() 方法中完成了 SPI 配置文件的查找以及相应扩展实现类的实例化,同时还实现了自动装配以及自动 Wrapper 包装等功能。其核心流程是这样的:

(1)获取 cachedClasses 缓存,根据扩展名从 cachedClasses 缓存中获取扩展实现类。如果 cachedClasses 未初始化,则会扫描前面介绍的三个 SPI 目录获取查找相应的 SPI 配置文件,然后加载其中的扩展实现类,最后将扩展名和扩展实现类的映射关系记录到 cachedClasses 缓存中。这部分逻辑在 loadExtensionClasses() 和 loadDirectory() 方法中

(2)根据扩展实现类从 EXTENSION_INSTANCES 缓存中查找相应的实例。如果查找失败,会通过反射创建扩展实现对象。

(3)自动装配扩展实现对象中的属性(即调用其 setter)。这里涉及 ExtensionFactory 以及自动装配的相关内容

(4)自动包装扩展实现对象。这里涉及 Wrapper 类以及自动包装特性的相关内容

(5)如果扩展实现类实现了 Lifecycle 接口,在 initExtension() 方法中会调用 initialize() 方法进行初始化

@SuppressWarnings("unchecked")

private T createExtension(String name) {

// 获取 cachedClasses 缓存,根据扩展名从 cachedClasses 缓存中获取扩展实现类。

// 如果 cachedClasses 未初始化,则会扫描前面介绍的三个 SPI 目录获取查找相应的 SPI 配置文件,

// 然后加载其中的扩展实现类,最后将扩展名和扩展实现类的映射关系记录到 cachedClasses 缓存中。

// 这部分逻辑在 loadExtensionClasses() 和 loadDirectory() 方法中。

Class<?> clazz = getExtensionClasses().get(name); // --- 1

if (clazz == null) {

throw findException(name);

}

try {

// 根据扩展实现类从 EXTENSION_INSTANCES 缓存中查找相应的实例。

// 如果查找失败,会通过反射创建扩展实现对象。

T instance = (T) EXTENSION_INSTANCES.get(clazz); // --- 2

if (instance == null) {

EXTENSION_INSTANCES.putIfAbsent(clazz, clazz.newInstance());

instance = (T) EXTENSION_INSTANCES.get(clazz);

}

// 自动装配扩展实现对象中的属性(即调用其 setter)。

// 这里涉及到 ExtensionFactory 以及自动装配的相关内容,本课时后面会进行详细介绍。

injectExtension(instance); // --- 3

// 自动包装扩展实现对象。这里涉及到 Wrapper 类以及自动包装特性的相关内容,本课时后面会进行详细介绍。

Set<Class<?>> wrapperClasses = cachedWrapperClasses; // --- 4

if (CollectionUtils.isNotEmpty(wrapperClasses)) {

for (Class<?> wrapperClass : wrapperClasses) {

instance = injectExtension((T) wrapperClass.getConstructor(type).newInstance(instance));

}

}

// 如果扩展实现类实现了 Lifecycle 接口,在 initExtension() 方法中会调用 initialize() 方法进行初始化。

initExtension(instance); // --5

return instance;

} catch (Throwable t) {

throw new IllegalStateException("Extension instance (name: " + name + ", class: " +

type + ") couldn't be instantiated: " + t.getMessage(), t);

}

}

③@Adaptive注解与适配器

@Adaptive 注解用来实现 Dubbo 的适配器功能,

Dubbo 中的 ExtensionFactory 接口有三个实现类,如下图所示,ExtensionFactory 接口上有 @SPI 注解,AdaptiveExtensionFactory 实现类上有 @Adaptive 注解。

AdaptiveExtensionFactory 不实现任何具体的功能,而是用来适配 ExtensionFactory 的 SpiExtensionFactory 和 SpringExtensionFactory 这两种实现。AdaptiveExtensionFactory 会根据运行时的一些状态来选择具体调用 ExtensionFactory 的哪个实现。

@Adaptive 注解还可以加到接口方法之上,Dubbo 会动态生成适配器类。例如,Transporter接口有两个被 @Adaptive 注解修饰的方法:

@SPI("netty")

public interface Transporter {

@Adaptive({Constants.SERVER_KEY, Constants.TRANSPORTER_KEY})

RemotingServer bind(URL url, ChannelHandler handler) throws RemotingException;

@Adaptive({Constants.CLIENT_KEY, Constants.TRANSPORTER_KEY})

Client connect(URL url, ChannelHandler handler) throws RemotingException;

}

Dubbo 会生成一个 Transporter$Adaptive 适配器类,该类继承了 Transporter 接口

public class Transporter$Adaptive implements Transporter {

public org.apache.dubbo.remoting.Client connect(URL arg0, ChannelHandler arg1) throws RemotingException {

if (arg0 == null) throw new IllegalArgumentException("url == null");

URL url = arg0;

// 确定扩展名,优先从URL中的client参数获取,其次是transporter参数

// 这两个参数名称由@Adaptive注解指定,最后是@SPI注解中的默认值

String extName = url.getParameter("client",

url.getParameter("transporter", "netty"));

if (extName == null)

throw new IllegalStateException("...");

// 通过ExtensionLoader加载Transporter接口的指定扩展实现

Transporter extension = (Transporter) ExtensionLoader

.getExtensionLoader(Transporter.class)

.getExtension(extName);

return extension.connect(arg0, arg1);

}

... // 省略bind()方法

}

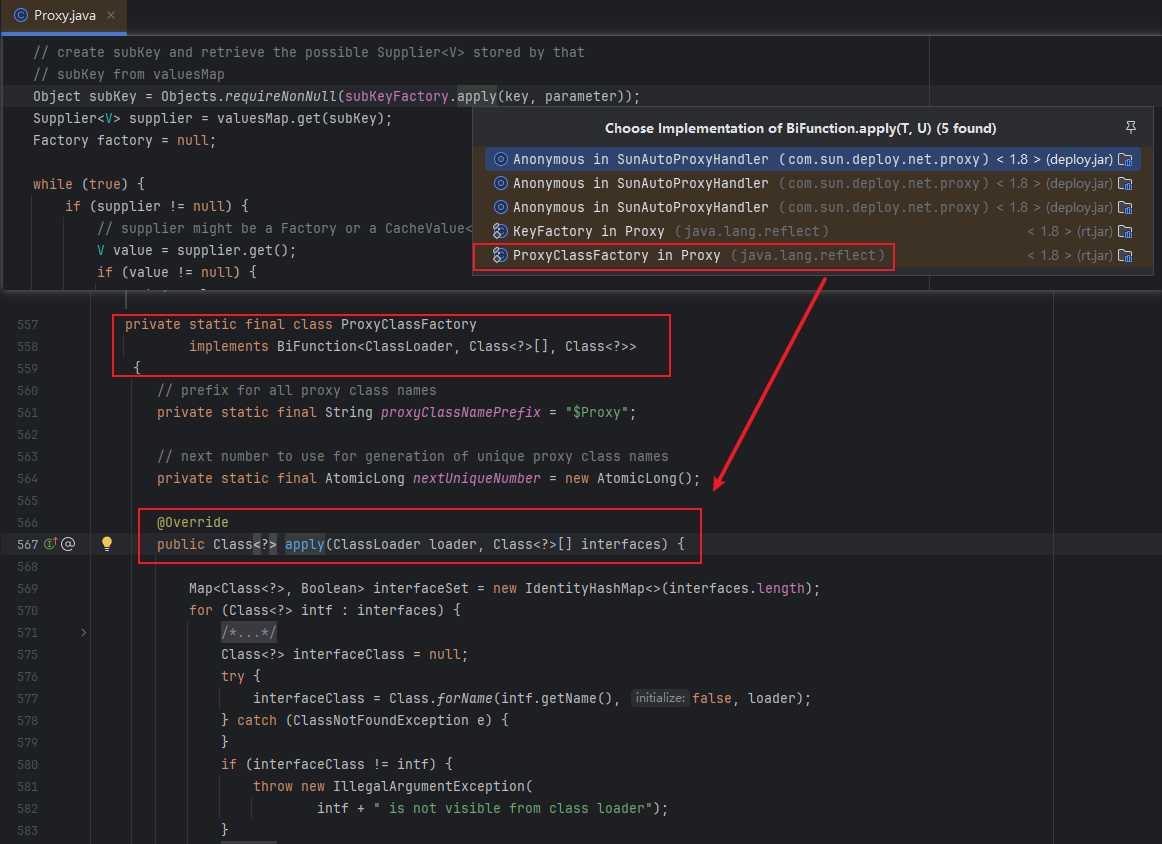

Dubbo 动态生成适配类的逻辑在org.apache.dubbo.common.extension.ExtensionLoader#createAdaptiveExtensionClass。其中涉及的 javassist 等方面的知识

适配器类及其实例保存在 ExtensionLoader 类的 cachedAdaptiveClass 和 cachedAdaptiveInstance 属性里

private Class<?> createAdaptiveExtensionClass() {

String code = new AdaptiveClassCodeGenerator(type, cachedDefaultName).generate();

ClassLoader classLoader = findClassLoader();

org.apache.dubbo.common.compiler.Compiler compiler = ExtensionLoader.getExtensionLoader(org.apache.dubbo.common.compiler.Compiler.class).getAdaptiveExtension();

return compiler.compile(code, classLoader);

}

明确了 @Adaptive 注解的作用之后,回到 ExtensionLoader.createExtension() 方法,其中在扫描 SPI 配置文件的时候,会调用 loadClass() 方法加载 SPI 配置文件中指定的类,如下图所示:

loadClass() 方法中会识别加载扩展实现类上的 @Adaptive 注解,将该扩展实现的类型缓存到 cachedAdaptiveClass 这个实例字段上(volatile修饰):

private void loadClass(){

if (clazz.isAnnotationPresent(Adaptive.class)) {

// 缓存到cachedAdaptiveClass字段

cacheAdaptiveClass(clazz, overridden);

} else ... // 省略其他分支

}

可以通过 ExtensionLoader.getAdaptiveExtension() 方法获取适配器实例,并将该实例缓存到 cachedAdaptiveInstance 字段(Holder类型)中,核心流程如下:

- ① 检查 cachedAdaptiveInstance 字段中是否已缓存了适配器实例,如果已缓存,则直接返回该实例即可

- ② 调用 getExtensionClasses() 方法,其中就会触发前文介绍的 loadClass() 方法,完成 cachedAdaptiveClass 字段的填充。

- ③ 如果存在 @Adaptive 注解修饰的扩展实现类,该类就是适配器类,通过 newInstance() 将其实例化即可。如果不存在 @Adaptive 注解修饰的扩展实现类,就需要通过 createAdaptiveExtensionClass() 方法扫描扩展接口中方法上的 @Adaptive 注解,动态生成适配器类,然后实例化

- ④ 调用 injectExtension() 方法进行自动装配,就能得到一个完整的适配器实例

- ⑤将适配器实例缓存到 cachedAdaptiveInstance 字段,然后返回适配器实例。

此外,还可以通过 API 方式(addExtension() 方法)设置 cachedAdaptiveClass 这个字段,指定适配器类型。总之,适配器什么实际工作都不用做,就是根据参数和状态选择其他实现来完成工作

④ 自动包装特性

Dubbo 中的一个扩展接口可能有多个扩展实现类,这些扩展实现类可能会包含一些相同的逻辑,如果在每个实现类中都写一遍,那么这些重复代码就会变得很难维护。Dubbo 提供的自动包装特性,就可以解决这个问题。

Dubbo 将多个扩展实现类的公共逻辑,抽象到 Wrapper 类中,Wrapper 类与普通的扩展实现类一样,也实现了扩展接口,在获取真正的扩展实现对象时,在其外面包装一层 Wrapper 对象,可以理解成一层装饰器。

了解了 Wrapper 类的基本功能,回到 ExtensionLoader.loadClass() 方法中,可以看到:

private void loadClass(){

... // 省略前面对@Adaptive注解的处理

} else if (isWrapperClass(clazz)) { // ---1

cacheWrapperClass(clazz); // ---2

} else ... // 省略其他分支

}

① 在 isWrapperClass() 方法中,会判断该扩展实现类是否包含拷贝构造函数(即构造函数只有一个参数且为扩展接口类型),如果包含,则为 Wrapper 类,这就是判断 Wrapper 类的标准。

② 将 Wrapper 类记录到 cachedWrapperClasses(Set>类型)这个实例字段中进行缓存

前面在介绍 createExtension() 方法时的 4 处,有下面这段代码,其中会遍历全部 Wrapper 类并一层层包装到真正的扩展实例对象外层:

Set<Class<?>> wrapperClasses = cachedWrapperClasses;

if (CollectionUtils.isNotEmpty(wrapperClasses)) {

for (Class<?> wrapperClass : wrapperClasses) {

instance = injectExtension((T) wrapperClass

.getConstructor(type).newInstance(instance));

}

}

⑤ 自动装配特性

在 createExtension() 方法中可以看到,Dubbo SPI 在拿到扩展实现类的对象(以及 Wrapper 类的对象)之后,还会调用 injectExtension() 方法扫描其全部 setter 方法,并根据 setter 方法的名称以及参数的类型,加载相应的扩展实现,然后调用相应的 setter 方法填充属性,这就实现了 Dubbo SPI 的自动装配特性。简单来说,自动装配属性就是在加载一个扩展点的时候,将其依赖的扩展点一并加载,并进行装配。

下面简单看一下 injectExtension() 方法的具体实现:

private T injectExtension(T instance) {

if (objectFactory == null) { // 检测objectFactory字段

return instance;

}

for (Method method : instance.getClass().getMethods()) {

... // 如果不是setter方法,忽略该方法(略)

if (method.getAnnotation(DisableInject.class) != null) {

continue; // 如果方法上明确标注了@DisableInject注解,忽略该方法

}

// 根据setter方法的参数,确定扩展接口

Class<?> pt = method.getParameterTypes()[0];

... // 如果参数为简单类型,忽略该setter方法(略)

// 根据setter方法的名称确定属性名称

String property = getSetterProperty(method);

// 加载并实例化扩展实现类

Object object = objectFactory.getExtension(pt, property);

if (object != null) {

method.invoke(instance, object); // 调用setter方法进行装配

}

}

return instance;

}

injectExtension() 方法实现的自动装配依赖了 ExtensionFactory(即 objectFactory 字段),前面我们提到过 ExtensionFactory 有 SpringExtensionFactory 和 SpiExtensionFactory 两个真正的实现(还有一个实现是 AdaptiveExtensionFactory 是适配器)。下面我们分别介绍下这两个真正的实现。

第一个,SpiExtensionFactory。 根据扩展接口获取相应的适配器,没有到属性名称:

@Override

public <T> T getExtension(Class<T> type, String name) {

if (type.isInterface() && type.isAnnotationPresent(SPI.class)) {

// 查找type对应的ExtensionLoader实例

ExtensionLoader<T> loader = ExtensionLoader

.getExtensionLoader(type);

if (!loader.getSupportedExtensions().isEmpty()) {

return loader.getAdaptiveExtension(); // 获取适配器实现

}

}

return null;

}

第二个,SpringExtensionFactory。 将属性名称作为 Spring Bean 的名称,从 Spring 容器中获取 Bean:

public <T> T getExtension(Class<T> type, String name) {

... // 检查:type必须为接口且必须包含@SPI注解(略)

for (ApplicationContext context : CONTEXTS) {

// 从Spring容器中查找Bean

T bean = BeanFactoryUtils.getOptionalBean(context,name,type);

if (bean != null) {

return bean;

}

}

return null;

}

⑥ @Activate注解与自动激活特性

这里以 Dubbo 中的 Filter 为例说明自动激活特性的含义,org.apache.dubbo.rpc.Filter 接口有非常多的扩展实现类,在一个场景中可能需要某几个 Filter 扩展实现类协同工作,而另一个场景中可能需要另外几个实现类一起工作。这样,就需要一套配置来指定当前场景中哪些 Filter 实现是可用的,这就是 @Activate 注解要做的事情。

@Activate 注解标注在扩展实现类上,有 group、value 以及 order 三个属性

- group 属性:修饰的实现类是在 Provider 端被激活还是在 Consumer 端被激活

- value 属性:修饰的实现类只在 URL 参数中出现指定的 key 时才会被激活

- order 属性:用来确定扩展实现类的排序

loadClass() 方法对 @Activate 的扫描,其中会将包含 @Activate 注解的实现类缓存到 cachedActivates 这个实例字段(Map类型,Key为扩展名,Value为 @Activate 注解):

private void loadClass(Map<String, Class<?>> extensionClasses, java.net.URL resourceURL, Class<?> clazz, String name,

boolean overridden) throws NoSuchMethodException {

if (!type.isAssignableFrom(clazz)) {

throw new IllegalStateException("Error occurred when loading extension class (interface: " +

type + ", class line: " + clazz.getName() + "), class "

+ clazz.getName() + " is not subtype of interface.");

}

if (clazz.isAnnotationPresent(Adaptive.class)) {

// 缓存到cachedAdaptiveClass字段

cacheAdaptiveClass(clazz, overridden);

} else if (isWrapperClass(clazz)) { // --1

// 1.在 isWrapperClass() 方法中,会判断该扩展实现类是否包含拷贝构造函数

// (即构造函数只有一个参数且为扩展接口类型),如果包含,则为 Wrapper 类,这就是判断 Wrapper 类的标准。

// 2.将 Wrapper 类记录到 cachedWrapperClasses(Set<Class<?>>类型)这个实例字段中进行缓存。

cacheWrapperClass(clazz); // ---2

} else {

clazz.getConstructor(); // 扩展实现类必须有无参构造函数

if (StringUtils.isEmpty(name)) {

name = findAnnotationName(clazz);

if (name.length() == 0) {

throw new IllegalStateException("No such extension name for the class " + clazz.getName() + " in the config " + resourceURL);

}

}

String[] names = NAME_SEPARATOR.split(name);

if (ArrayUtils.isNotEmpty(names)) {

// 将包含@Activate注解的实现类缓存到cachedActivates集合中

cacheActivateClass(clazz, names[0]);

for (String n : names) {

cacheName(clazz, n);

saveInExtensionClass(extensionClasses, clazz, n, overridden);

}

}

}

}

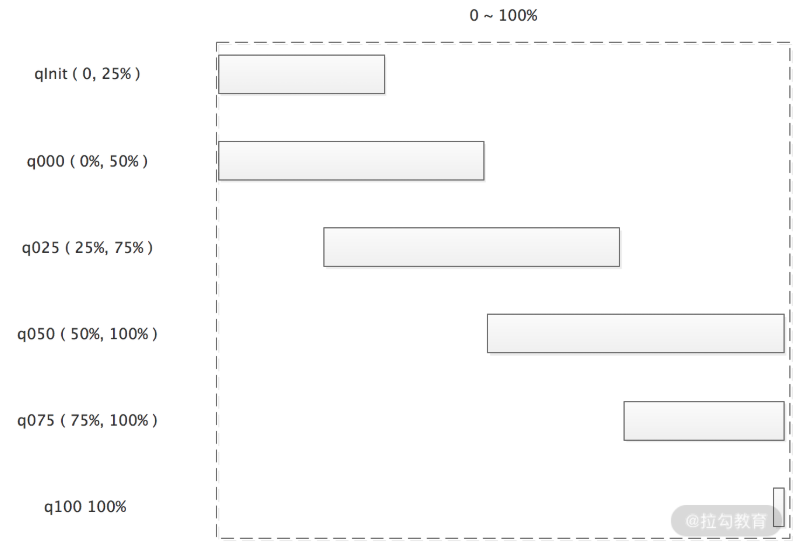

使用 cachedActivates 这个集合的地方是 getActivateExtension() 方法。首先来关注 getActivateExtension() 方法的参数:url 中包含了配置信息,values 是配置中指定的扩展名,group 为 Provider 或 Consumer。下面是 getActivateExtension() 方法的核心逻辑:

(1)获取默认激活的扩展集合。默认激活的扩展实现类有几个条件:①在 cachedActivates 集合中存在;②@Activate 注解指定的 group 属性与当前 group 匹配;③扩展名没有出现在 values 中(即未在配置中明确指定,也未在配置中明确指定删除);④URL 中出现了 @Activate 注解中指定的 Key

(2)按照 @Activate 注解中的 order 属性对默认激活的扩展集合进行排序

(3)按序添加自定义扩展实现类的对象

public List<T> getActivateExtension(URL url, String[] values, String group) {

List<T> activateExtensions = new ArrayList<>();

// values就是扩展名

List<String> names = values == null ? new ArrayList<>(0) : asList(values);

if (!names.contains(REMOVE_VALUE_PREFIX + DEFAULT_KEY)) { // ---1

getExtensionClasses(); // 触发cachedActivates等缓存字段的加载

for (Map.Entry<String, Object> entry : cachedActivates.entrySet()) {

String name = entry.getKey(); // 扩展名

Object activate = entry.getValue(); // @Activate注解

String[] activateGroup, activateValue;

if (activate instanceof Activate) { // @Activate注解中的配置

activateGroup = ((Activate) activate).group();

activateValue = ((Activate) activate).value();

} else if (activate instanceof com.alibaba.dubbo.common.extension.Activate) {

activateGroup = ((com.alibaba.dubbo.common.extension.Activate) activate).group();

activateValue = ((com.alibaba.dubbo.common.extension.Activate) activate).value();

} else {

continue;

}

if (isMatchGroup(group, activateGroup) // 匹配group

&& !names.contains(name) // 匹配扩展名

&& !names.contains(REMOVE_VALUE_PREFIX + name) // 如果包含"-"表示不激活该扩展实现

&& isActive(activateValue, url)) // 检测URL中是否出现了指定的Key

{

activateExtensions.add(getExtension(name)); // 加载扩展实现

}

}

// 排序 --- 2

activateExtensions.sort(ActivateComparator.COMPARATOR);

}

List<T> loadedExtensions = new ArrayList<>();

for (int i = 0; i < names.size(); i++) { // ---3

String name = names.get(i);

// 通过"-"开头的配置明确指定不激活的扩展实现,直接就忽略了

if (!name.startsWith(REMOVE_VALUE_PREFIX)

&& !names.contains(REMOVE_VALUE_PREFIX + name)) {

if (DEFAULT_KEY.equals(name)) {

if (!loadedExtensions.isEmpty()) {

// 按照顺序,将自定义的扩展添加到默认扩展集合前面

activateExtensions.addAll(0, loadedExtensions);

loadedExtensions.clear();

}

} else {

loadedExtensions.add(getExtension(name));

}

}

}

if (!loadedExtensions.isEmpty()) {

// 按照顺序,将自定义的扩展添加到默认扩展集合后面

activateExtensions.addAll(loadedExtensions);

}

return activateExtensions;

}

举例分析

假设 cachedActivates 集合缓存的扩展实现如下表所示:

| 扩展名 | @Activate中的group | @Activate中的order |

|---|---|---|

| demoFilter1 | Provider | 6 |

| demoFilter2 | Provider | 5 |

| demoFilter3 | Provider | 4 |

| demoFilter4 | Provider | 3 |

| demoFilter5 | Consumer | 2 |

| demoFilter6 | Provider | 1 |

在 Provider 端调用 getActivateExtension() 方法时传入的 values 配置为 “demoFilter3、demoFilter2、default、demoFilter1”,那么根据上面的逻辑:

① 得到默认激活的扩展实实现集合中有 [ demoFilter4, demoFilter6 ];

② 排序后为 [ demoFilter6, demoFilter4 ];

③ 按序添加自定义扩展实例之后得到 [ demoFilter3, demoFilter6, demoFilter4, demoFilter1 ]

④ 海量定时任务:时间轮

学习目标

- todo 海量定时任务处理

1.时间轮

在很多开源框架中,都需要定时任务的管理功能,例如 ZooKeeper、Netty、Quartz、Kafka 以及 Linux 操作系统。

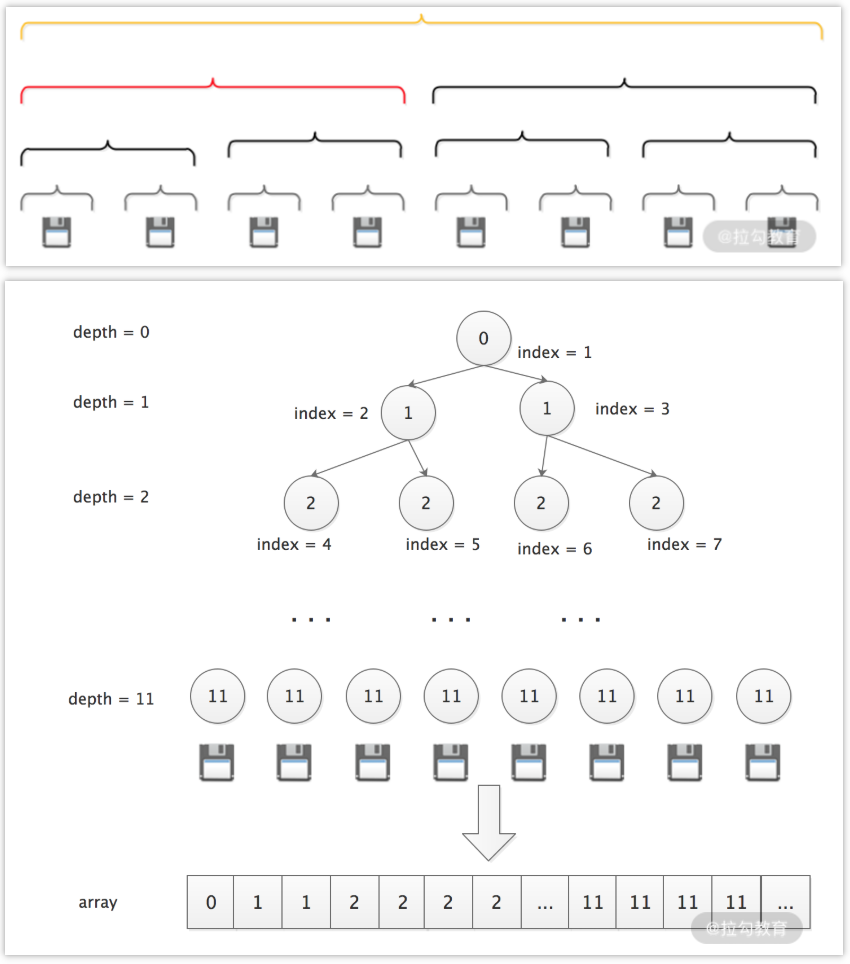

JDK 提供的 java.util.Timer 和 DelayedQueue 等工具类,可以实现简单的定时任务管理,其底层实现使用的是堆这种数据结构,存取操作的复杂度都是 O(nlog(n)),无法支持大量的定时任务。在定时任务量比较大、性能要求比较高的场景中,为了将定时任务的存取操作以及取消操作的时间复杂度降为 O(1),一般会使用时间轮的方式。

时间轮是一种高效的、批量管理定时任务的调度模型。时间轮一般会实现成一个环形结构,类似一个时钟,分为很多槽,一个槽代表一个时间间隔,每个槽使用双向链表存储定时任务;指针周期性地跳动,跳动到一个槽位,就执行该槽位的定时任务。

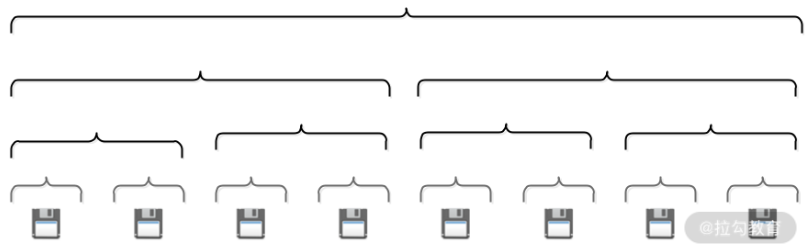

需要注意的是,单层时间轮的容量和精度都是有限的,对于精度要求特别高、时间跨度特别大或是海量定时任务需要调度的场景,通常会使用多级时间轮以及持久化存储与时间轮结合的方案。

2.核心设计

① 接口定义

Dubbo 的时间轮实现位于 dubbo-common 模块的 org.apache.dubbo.common.timer 包中,下面就来分析时间轮涉及的核心接口和实现。

在 Dubbo 中,所有的定时任务都要继承 TimerTask 接口。TimerTask 接口非常简单,只定义了一个 run() 方法,该方法的入参是一个 Timeout 接口的对象。

public interface TimerTask {

void run(Timeout timeout) throws Exception;

}

Timeout 对象与 TimerTask 对象一一对应,两者的关系类似于线程池返回的 Future 对象与提交到线程池中的任务对象之间的关系。通过 Timeout 对象,不仅可以查看定时任务的状态,还可以操作定时任务(例如取消关联的定时任务)。Timeout 接口中的方法如下图所示

public interface Timeout {

Timer timer();

TimerTask task();

boolean isExpired();

boolean isCancelled();

boolean cancel();

}

Timer 接口定义了定时器的基本行为,如下图所示,其核心是 newTimeout() 方法:提交一个定时任务(TimerTask)并返回关联的 Timeout 对象,这有点类似于向线程池提交任务的感觉

public interface Timer {

Timeout newTimeout(TimerTask task, long delay, TimeUnit unit);

Set<Timeout> stop();

boolean isStop();

}

② 接口实现

HashedWheelTimeout

HashedWheelTimeout :HashedWheelTimeout 是 Timeout 接口的唯一实现,是 HashedWheelTimer 的内部类。HashedWheelTimeout 扮演了两个角色:

- 第一个,时间轮中双向链表的节点,即定时任务 TimerTask 在 HashedWheelTimer 中的容器。

- 第二个,定时任务 TimerTask 提交到 HashedWheelTimer 之后返回的句柄(Handle),用于在时间轮外部查看和控制定时任务。

HashedWheelTimeout 中的核心字段如下:

- prev、next(HashedWheelTimeout类型),分别对应当前定时任务在链表中的前驱节点和后继节点

- task(TimerTask类型),指实际被调度的任务

- deadline(long类型),指定时任务执行的时间。这个时间是在创建 HashedWheelTimeout 时指定的,计算公式是:currentTime(创建 HashedWheelTimeout 的时间) + delay(任务延迟时间) - startTime(HashedWheelTimer 的启动时间),时间单位为纳秒

- state(volatile int类型),指定时任务当前所处状态,可选的有三个,分别是 INIT(0)、CANCELLED(1)和 EXPIRED(2)。另外,还有一个 STATE_UPDATER 字段(AtomicIntegerFieldUpdater类型)实现 state 状态变更的原子性

- remainingRounds(long类型),指当前任务剩余的时钟周期数。时间轮所能表示的时间长度是有限的,在任务到期时间与当前时刻的时间差,超过时间轮单圈能表示的时长,就出现了套圈的情况,需要该字段值表示剩余的时钟周期

HashedWheelTimeout 中的核心方法有:

- isCancelled()、isExpired() 、state() 方法, 主要用于检查当前 HashedWheelTimeout 状态

- cancel() 方法, 将当前 HashedWheelTimeout 的状态设置为 CANCELLED,并将当前 HashedWheelTimeout 添加到 cancelledTimeouts 队列中等待销毁

- expire() 方法, 当任务到期时,会调用该方法将当前 HashedWheelTimeout 设置为 EXPIRED 状态,然后调用其中的 TimerTask 的 run() 方法执行定时任务

- remove() 方法, 将当前 HashedWheelTimeout 从时间轮中删除

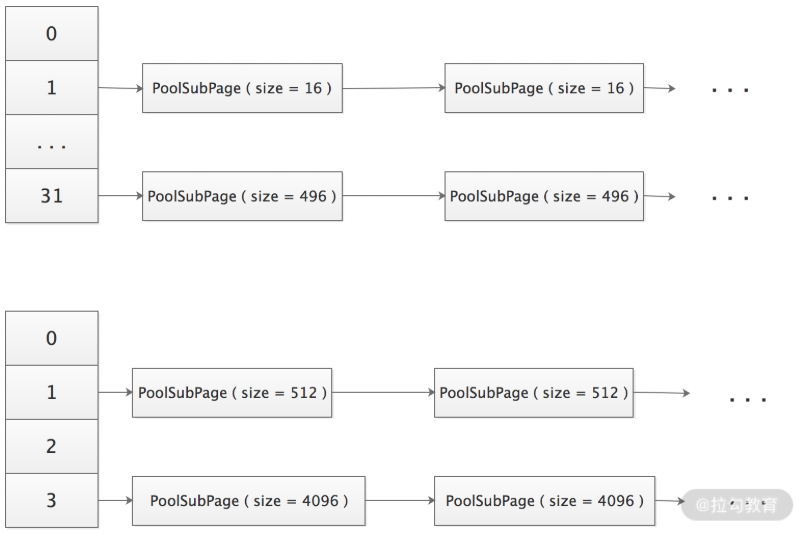

HashedWheelBucket

HashedWheelBucket 是时间轮中的一个槽,时间轮中的槽实际上就是一个用于缓存和管理双向链表的容器,双向链表中的每一个节点就是一个 HashedWheelTimeout 对象,也就关联了一个 TimerTask 定时任务。

HashedWheelBucket 持有双向链表的首尾两个节点,分别是 head 和 tail 两个字段,再加上每个 HashedWheelTimeout 节点均持有前驱和后继的引用,这样就可以正向或是逆向遍历整个双向链表了。

HashedWheelBucket 中的核心方法:

- addTimeout() 方法:新增 HashedWheelTimeout 到双向链表的尾部

- pollTimeout() 方法:移除双向链表中的头结点,并将其返回

- remove() 方法:从双向链表中移除指定的 HashedWheelTimeout 节点

- clearTimeouts() 方法:循环调用 pollTimeout() 方法处理整个双向链表,并返回所有未超时或者未被取消的任务

- expireTimeouts() 方法:遍历双向链表中的全部 HashedWheelTimeout 节点。 在处理到期的定时任务时,会通过 remove() 方法取出,并调用其 expire() 方法执行;对于已取消的任务,通过 remove() 方法取出后直接丢弃;对于未到期的任务,会将 remainingRounds 字段(剩余时钟周期数)减一

HashedWheelTimer

HashedWheelTimer 是 Timer 接口的实现,它通过时间轮算法实现了一个定时器。HashedWheelTimer 会根据当前时间轮指针选定对应的槽(HashedWheelBucket),从双向链表的头部开始迭代,对每个定时任务(HashedWheelTimeout)进行计算,属于当前时钟周期则取出运行,不属于则将其剩余的时钟周期数减一操作。

HashedWheelTimer 的核心属性:

- workerState(volatile int类型):时间轮当前所处状态,可选值有 init、started、shutdown。同时,有相应的 AtomicIntegerFieldUpdater 实现 workerState 的原子修改

- startTime(long类型):当前时间轮的启动时间,提交到该时间轮的定时任务的 deadline 字段值均以该时间戳为起点进行计算

- wheel(HashedWheelBucket[]类型):该数组就是时间轮的环形队列,每一个元素都是一个槽。当指定时间轮槽数为 n 时,实际上会取大于且最靠近 n 的 2 的幂次方值

- timeouts、cancelledTimeouts(LinkedBlockingQueue类型):timeouts 队列用于缓冲外部提交时间轮中的定时任务,cancelledTimeouts 队列用于暂存取消的定时任务HashedWheelTimer 会在处理 HashedWheelBucket 的双向链表之前,先处理这两个队列中的数据

- tick(long类型):该字段在 HashedWheelTimer$Worker 中,是时间轮的指针,是一个步长为 1 的单调递增计数器

- mask(int类型):掩码, mask = wheel.length - 1,执行 ticks & mask 便能定位到对应的时钟槽

- ticksDuration(long类型):时间指针每次加 1 所代表的实际时间,单位为纳秒

- pendingTimeouts(AtomicLong类型):当前时间轮剩余的定时任务总数

- workerThread(Thread类型):时间轮内部真正执行定时任务的线程

- worker(Worker类型):真正执行定时任务的逻辑封装这个 Runnable 对象中

时间轮对外提供了一个 newTimeout() 接口用于提交定时任务,在定时任务进入到 timeouts 队列之前会先调用 start() 方法启动时间轮,其中会完成下面两个关键步骤:

- (1)确定时间轮的 startTime 字段;

- (2)启动 workerThread 线程,开始执行 worker 任务;

之后根据 startTime 计算该定时任务的 deadline 字段,最后才能将定时任务封装成 HashedWheelTimeout 并添加到 timeouts 队列

时间轮指针一次转动的全流程分析

- (1)时间轮指针转动,时间轮周期开始

- (2)清理用户主动取消的定时任务,这些定时任务在用户取消时,会记录到 cancelledTimeouts 队列中。在每次指针转动的时候,时间轮都会清理该队列

- (3)将缓存在 timeouts 队列中的定时任务转移到时间轮中对应的槽中

- (4)根据当前指针定位对应槽,处理该槽位的双向链表中的定时任务

- (5)检测时间轮的状态。如果时间轮处于运行状态,则循环执行上述步骤,不断执行定时任务。如果时间轮处于停止状态,则执行下面的步骤获取到未被执行的定时任务并加入 unprocessedTimeouts 队列:遍历时间轮中每个槽位,并调用 clearTimeouts() 方法;对 timeouts 队列中未被加入槽中循环调用 poll()

- (5)最后再次清理 cancelledTimeouts 队列中用户主动取消的定时任务

上述核心逻辑在 HashedWheelTimer$Worker.run() 方法中

3.Dubbo 中如何使用定时任务

在 Dubbo 中,时间轮并不直接用于周期性操作,而是只向时间轮提交执行单次的定时任务,在上一次任务执行完成的时候,调用 newTimeout() 方法再次提交当前任务,这样就会在下个周期执行该任务。即使在任务执行过程中出现了 GC、I/O 阻塞等情况,导致任务延迟或卡住,也不会有同样的任务源源不断地提交进来,导致任务堆积。

Dubbo 中对时间轮的应用主要体现在如下两个方面:

- 失败重试, 例如,Provider 向注册中心进行注册失败时的重试操作,或是 Consumer 向注册中心订阅时的失败重试等

- 周期性定时任务, 例如,定期发送心跳请求,请求超时的处理,或是网络连接断开后的重连机制

⑤ Zookeeper & Curator

学习目标

- Dubbo 的 注册中心

- Zookeeper 核心概念 及 工作原理

- Zookeeper 集群中各个节点的角色以及职能

- Zookeeper 中存储数据的逻辑结构、ZNode 节点的相关特性

- Zookeeper 集群读写机制的核心流程

- Zookeeper 集群的崩溃恢复流程

- Zookeeper 客户端(ZkClient VS Curator)

- 对比其他zk客户端(存在API功能不足、文档可读性差、重试机制不足等问题),Curator的易用性占据很大的优势

- Curator 的基本操作API应用

- curator-x-discovery 在 RPC 场景中的应用:实现一个简易版本的RPC注册中心,完成服务注册、服务发现功能

- curator-recipies 的功能介绍

Dubbo Provider 在启动时会将自身的服务信息整理成 URL 注册到注册中心,Dubbo Consumer 在启动时会向注册中心订阅感兴趣的 Provider 信息,之后 Provider 和 Consumer 才能建立连接,进行后续的交互。可见,一个稳定、高效的注册中心对基于 Dubbo 的微服务来说是至关重要的。

Dubbo 目前支持 Consul、etcd、Nacos、ZooKeeper、Redis 等多种开源组件作为注册中心,并且在 Dubbo 源码也有相应的接入模块。

Dubbo 官方推荐使用 ZooKeeper 作为注册中心,它是在实际生产中最常用的注册中心实现。要与 ZooKeeper 集群进行交互,可以使用 ZooKeeper 原生客户端或是 ZkClient、Apache Curator 等第三方开源客户端。在 dubbo-registry-zookeeper 模块学习是可以了解到Dubbo 底层使用的是 Apache Curator。Apache Curator 是实践中最常用的 ZooKeeper 客户端

1.Zookeeper 核心概念及工作原理

⚽ Zookeeper 核心概念

Apache ZooKeeper 是一个针对分布式系统的、可靠的、可扩展的协调服务,它通常作为统一命名服务、统一配置管理、注册中心(分布式集群管理)、分布式锁服务、Leader 选举服务等角色出现。很多分布式系统都依赖与 ZooKeeper 集群实现分布式系统间的协调调度,例如:Dubbo、HDFS 2.x、HBase、Kafka 等。ZooKeeper 已经成为现代分布式系统的标配。

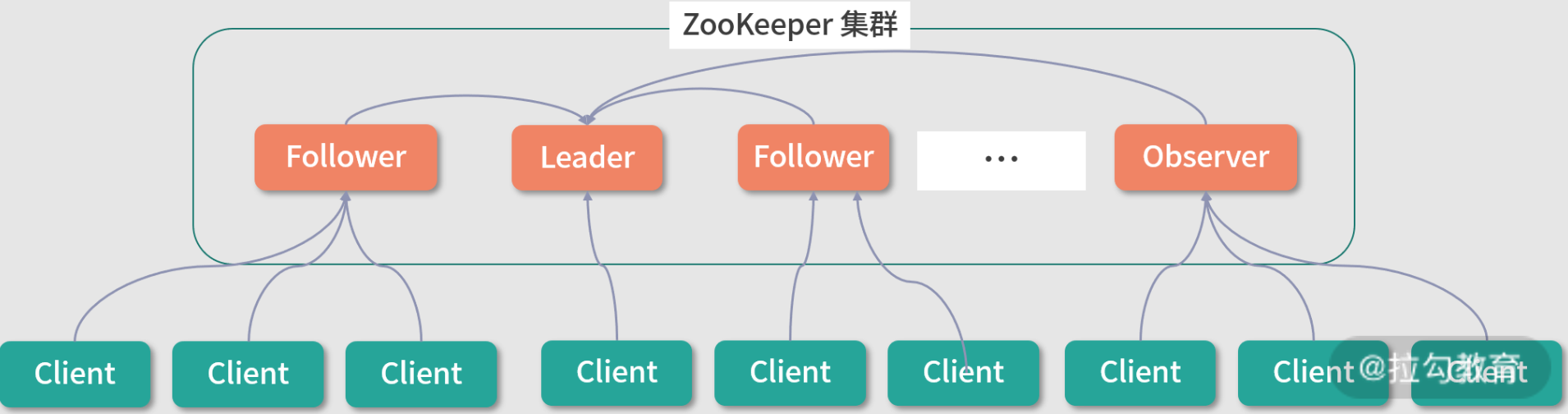

ZooKeeper 集群的核心架构(整体架构)

ZooKeeper 本身也是一个分布式应用程序,下图展示了 ZooKeeper 集群的核心架构

- Client 节点:从业务角度来看,这是分布式应用中的一个节点,通过 ZkClient 或是其他 ZooKeeper 客户端与 ZooKeeper 集群中的一个 Server 实例维持长连接,并定时发送心跳。从 ZooKeeper 集群的角度来看,它是 ZooKeeper 集群的一个客户端,可以主动查询或操作 ZooKeeper 集群中的数据,也可以在某些 ZooKeeper 节点(ZNode)上添加监听。当被监听的 ZNode 节点发生变化时,例如,该 ZNode 节点被删除、新增子节点或是其中数据被修改等,ZooKeeper 集群都会立即通过长连接通知 Client

- Leader 节点:ZooKeeper 集群的主节点,负责整个 ZooKeeper 集群的写操作,保证集群内事务处理的顺序性。同时,还要负责整个集群中所有 Follower 节点与 Observer 节点的数据同步

- Follower 节点:ZooKeeper 集群中的从节点,可以接收 Client 读请求并向 Client 返回结果,并不处理写请求,而是转发到 Leader 节点完成写入操作。另外,Follower 节点还会参与 Leader 节点的选举

- Observer 节点:ZooKeeper 集群中特殊的从节点,不会参与 Leader 节点的选举,其他功能与 Follower 节点相同。引入 Observer 角色的目的是增加 ZooKeeper 集群读操作的吞吐量,如果单纯依靠增加 Follower 节点来提高 ZooKeeper 的读吞吐量,那么有一个很严重的副作用,就是 ZooKeeper 集群的写能力会大大降低,因为 ZooKeeper 写数据时需要 Leader 将写操作同步给半数以上的 Follower 节点。引入 Observer 节点使得 ZooKeeper 集群在写能力不降低的情况下,大大提升了读操作的吞吐量

ZooKeeper 集群存储数据的逻辑结构

ZooKeeper 逻辑上是按照树型结构进行数据存储的(如下图),其中的节点称为 ZNode。每个 ZNode 有一个名称标识,即树根到该节点的路径(用 “/” 分隔),ZooKeeper 树中的每个节点都可以拥有子节点,这与文件系统的目录树类似。ZooKeeper 树型存储结构图示如下所示:

ZNode 节点类型有如下四种:

- 持久节点:持久节点创建后,会一直存在,不会因创建该节点的 Client 会话失效而删除

- 持久顺序节点:持久顺序节点的基本特性与持久节点一致,创建节点的过程中,ZooKeeper 会在其名字后自动追加一个单调增长的数字后缀,作为新的节点名

- 临时节点:创建临时节点的 ZooKeeper Client 会话失效之后,其创建的临时节点会被 ZooKeeper 集群自动删除。与持久节点的另一点区别是,临时节点下面不能再创建子节点

- 临时顺序节点:基本特性与临时节点一致,创建节点的过程中,ZooKeeper 会在其名字后自动追加一个单调增长的数字后缀,作为新的节点名

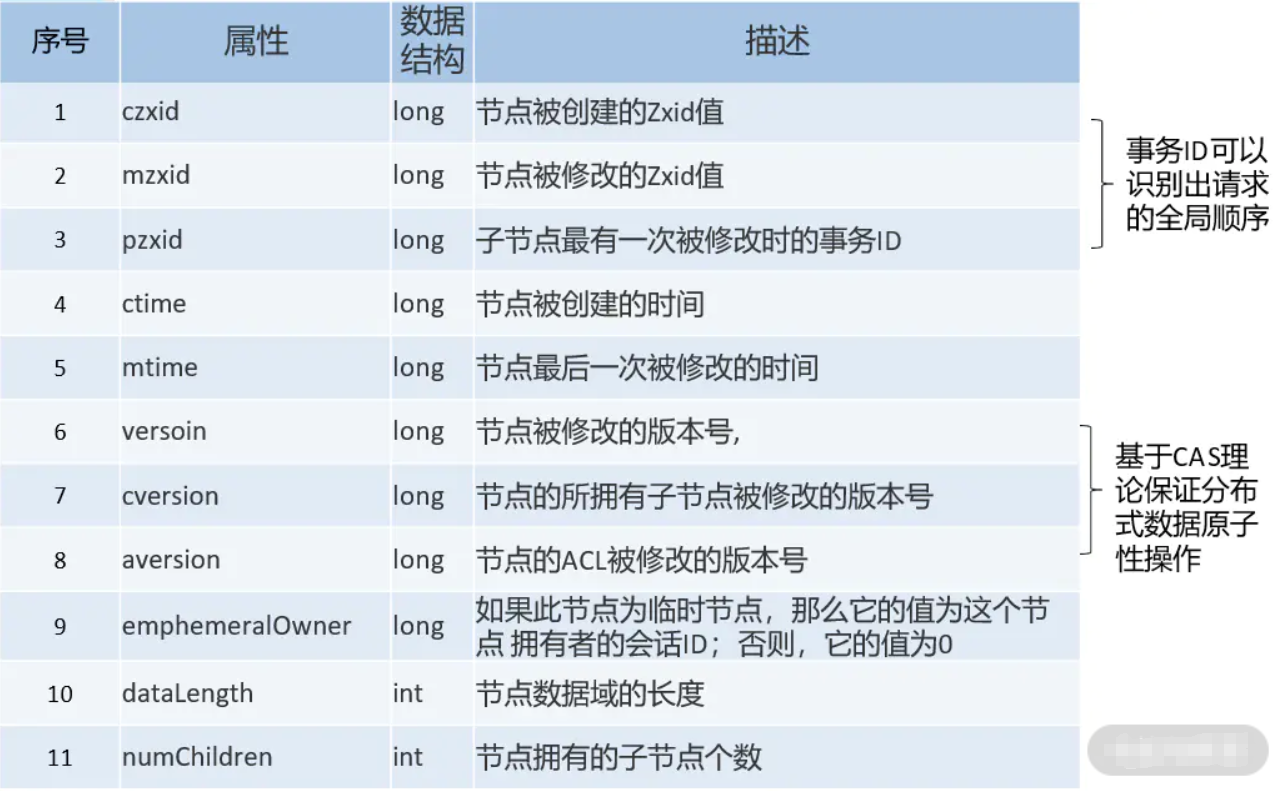

在每个 ZNode 中都维护着一个 stat 结构,记录了该 ZNode 的元数据,其中包括版本号、操作控制列表(ACL)、时间戳和数据长度等信息,如下表所示:

除了可以通过 ZooKeeper Client 对 ZNode 进行增删改查等基本操作,还可以注册 Watcher 监听 ZNode 节点、其中的数据以及子节点的变化。一旦监听到变化,则相应的 Watcher 即被触发,相应的 ZooKeeper Client 会立即得到通知。Watcher 有如下特点:

- 主动推送:Watcher 被触发时,由 ZooKeeper 集群主动将更新推送给客户端,而不需要客户端轮询

- 一次性:数据变化时,Watcher 只会被触发一次。如果客户端想得到后续更新的通知,必须要在 Watcher 被触发后重新注册一个 Watcher

- 可见性:如果一个客户端在读请求中附带 Watcher,Watcher 被触发的同时再次读取数据,客户端在得到 Watcher 消息之前肯定不可能看到更新后的数据。换句话说,更新通知先于更新结果

- 顺序性:如果多个更新触发了多个 Watcher ,那 Watcher 被触发的顺序与更新顺序一致

⚽ 消息广播流程

ZooKeeper 集群中三种角色的节点(Leader、Follower 和 Observer)都可以处理 Client 的读请求,因为每个节点都保存了相同的数据副本,直接进行读取即可返回给 Client。

对于写请求,如果 Client 连接的是 Follower 节点(或 Observer 节点),则在 Follower 节点(或 Observer 节点)收到写请求将会被转发到 Leader 节点。下面是 Leader 处理写请求的核心流程:

① Leader 节点接收写请求后,会为写请求赋予一个全局唯一的 zxid(64 位自增 id),通过 zxid 的大小比较就可以实现写操作的顺序一致性

② Leader 通过先进先出队列(会给每个 Follower 节点都创建一个队列,保证发送的顺序性),将带有 zxid 的消息作为一个 proposal(提案)分发给所有 Follower 节点

③ 当 Follower 节点接收到 proposal 之后,会先将 proposal 写到本地事务日志,写事务成功后再向 Leader 节点回一个 ACK 响应

④ 当 Leader 节点接收到过半 Follower 的 ACK 响应之后,Leader 节点就向所有 Follower 节点发送 COMMIT 命令,并在本地执行提交

⑤ 当 Follower 收到消息的 COMMIT 命令之后也会提交操作,写操作到此完成

⑥ 最后,Follower 节点会返回 Client 写请求相应的响应

写操作核心流程图示分析如下:

⚽ 崩溃恢复

上面写请求处理流程中,如果发生 Leader 节点宕机,整个 ZooKeeper 集群可能处于如下两种状态:

(1)当 Leader 节点收到半数以上 Follower 节点的 ACK 响应之后,会向各个 Follower 节点广播 COMMIT 命令,同时也会在本地执行 COMMIT 并向连接的客户端进行响应。如果在各个 Follower 收到 COMMIT 命令前 Leader 就宕机了,就会导致剩下的服务器没法执行这条消息

(2)当 Leader 节点生成 proposal 之后就宕机了,而其他 Follower 并没有收到此 proposal(或者只有一小部分 Follower 节点收到了这条 proposal),那么此次写操作就是执行失败的

在 Leader 宕机后,ZooKeeper 会进入崩溃恢复模式,重新进行 Leader 节点的选举。ZooKeeper 对新 Leader 有如下两个要求:

(1)对于原 Leader 已经提交了的 proposal,新 Leader 必须能够广播并提交,这样就需要选择拥有最大 zxid 值的节点作为 Leader;

(2)对于原 Leader 还未广播或只部分广播成功的 proposal,新 Leader 能够通知原 Leader 和已经同步了的 Follower 删除,从而保证集群数据的一致性;

ZooKeeper 选主使用的是 ZAB 协议,此处通过一个示例简单介绍 ZooKeeper 选主的大致流程。

比如,当前集群中有 5 个 ZooKeeper 节点构成,sid 分别为 1、2、3、4 和 5,zxid 分别为 10、10、9、9 和 8,此时,sid 为 1 的节点是 Leader 节点。实际上,zxid 包含了 epoch(高 32 位)和自增计数器(低 32 位) 两部分。其中,epoch 是“纪元”的意思,标识当前 Leader 周期,每次选举时 epoch 部分都会递增,这就防止了网络隔离之后,上一周期的旧 Leader 重新连入集群造成不必要的重新选举。该示例中假设各个节点的 epoch 都相同。

某一时刻,节点 1 的服务器宕机了,ZooKeeper 集群开始进行选主。由于无法检测到集群中其他节点的状态信息(处于 Looking 状态),因此每个节点都将自己作为被选举的对象来进行投票。于是 sid 为 2、3、4、5 的节点,投票情况分别为(2,10)、(3,9)、(4,9)、(5,8),同时各个节点也会接收到来自其他节点的投票(这里以(sid, zxid)的形式来标识一次投票信息)

- 对于节点 2 来说,接收到(3,9)、(4,9)、(5,8)的投票,对比后发现自己的 zxid 最大,因此不需要做任何投票变更

- 对于节点 3 来说,接收到(2,10)、(4,9)、(5,8)的投票,对比后由于 2 的 zxid 比自己的 zxid 要大,因此需要更改投票,改投(2,10),并将改投后的票发给其他节点

- 对于节点 4 来说,接收到(2,10)、(3,9)、(5,8)的投票,对比后由于 2 的 zxid 比自己的 zxid 要大,因此需要更改投票,改投(2,10),并将改投后的票发给其他节点

- 对于节点 5 来说,也是一样,最终改投(2,10)

经过第二轮投票后,集群中的每个节点都会再次收到其他机器的投票,然后开始统计投票,如果有过半的节点投了同一个节点,则该节点成为新的 Leader,这里显然节点 2 成了新 Leader节点。

Leader 节点此时会将 epoch 值加 1,并将新生成的 epoch 分发给各个 Follower 节点。各个 Follower 节点收到全新的 epoch 后,返回 ACK 给 Leader 节点,并带上各自最大的 zxid 和历史事务日志信息。Leader 选出最大的 zxid,并更新自身历史事务日志,示例中的节点 2 无须更新。Leader 节点紧接着会将最新的事务日志同步给集群中所有的 Follower 节点,只有当半数 Follower 同步成功,这个准 Leader 节点才能成为正式的 Leader 节点并开始工作

2.Zookeeper 客户端的选择

⚽ Zookeeper 客户端介绍

在实际工作中,直接使用客户端与 ZooKeeper 进行交互的次数比深入 ZooKeeper 底层进行扩展和二次开发的次数要多得多。从 ZooKeeper 架构的角度看,使用 Dubbo 的业务节点也只是一个 ZooKeeper 客户端罢了。

ZooKeeper 官方提供的客户端支持了一些基本操作,例如,创建会话、创建节点、读取节点、更新数据、删除节点和检查节点是否存在等,但在实际开发中只有这些简单功能是根本不够的。而且,ZooKeeper 本身的一些 API 也存在不足,例如:

- ZooKeeper 的 Watcher 是一次性的,每次触发之后都需要重新进行注册

- 会话超时之后,没有实现自动重连的机制

- ZooKeeper 提供了非常详细的异常,异常处理显得非常烦琐,对开发新手来说,非常不友好

- 只提供了简单的 byte[] 数组的接口,没有提供基本类型以及对象级别的序列化

- 创建节点时,如果节点存在抛出异常,需要自行检查节点是否存在

- 删除节点就无法实现级联删除

常见的第三方开源 ZooKeeper 客户端有 ZkClient 和 Apache Curator

ZkClient 是在 ZooKeeper 原生 API 接口的基础上进行了包装,虽然 ZkClient 解决了 ZooKeeper 原生 API 接口的很多问题,提供了非常简洁的 API 接口,实现了会话超时自动重连的机制,解决了 Watcher 反复注册等问题,但其缺陷也非常明显。例如,文档不全、重试机制难用、异常全部转换成了 RuntimeException、没有足够的参考示例等。可见,一个简单易用、高效可靠的 ZooKeeper 客户端是多么重要。

⚽ Apache Curator

**Apache Curator 是 Apache 基金会提供的一款 ZooKeeper 客户端,它提供了一套易用性和可读性非常强的 Fluent 风格的客户端 API ,可以帮助我们快速搭建稳定可靠的 ZooKeeper 客户端程序。**Curator 功能梳理如下:

| 名称 | 描述 |

|---|---|

| curator-framework | Zookeeper-API 的高层封装,简化Zookeeper客户端编程,添加了Zookeeper连接管理、重试机制、重复注册Watcher等功能 |

| curator-recipes | Zookeeper典型应用场景的实现(基于Curator Framework),例如Leader选举、分布式锁、Barrier分布式队列等 |

| curator-client | Zookeeper Client的封装,取代原生Zookeeper客户端,提供一些非常有用的客户端特性 |

| curator-x-discovery | 基于curator-framework上构建的服务发现实现 |

| curator-x-discoveryserver | 可以和curator-x-discovery一起使用的RESTful服务器 |

| curator-examples | 各种使用curator特性的案例 |

(1)基本操作

版本兼容性处理

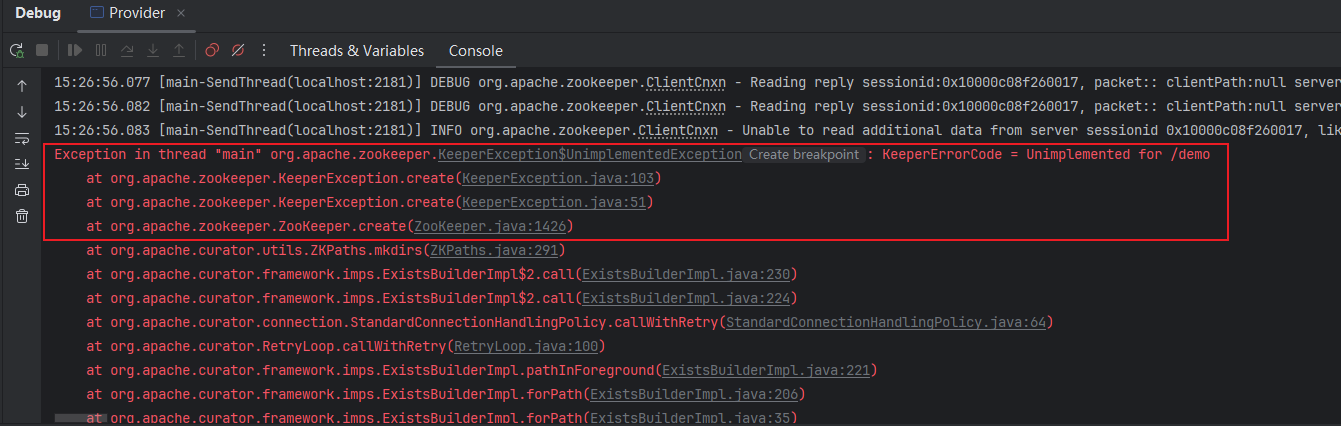

一开始使用zookeeper3.4.14版本和curator4.0.1进行搭配使用的时候报错,考虑版本兼容问题需注意zookeeper与curator的版本选择

11:09:34.615 [main-SendThread(127.0.0.1:2181)] DEBUG org.apache.zookeeper.ClientCnxn - Reading reply sessionid:0x10000c08f260001, packet:: clientPath:/zookeeper/config serverPath:/zookeeper/config finished:false header:: 1,4 replyHeader:: 1,177,-101 request:: '/zookeeper/config,T response::

11:09:34.616 [main-SendThread(127.0.0.1:2181)] DEBUG org.apache.zookeeper.ClientCnxn - Reading reply sessionid:0x10000c08f260001, packet:: clientPath:/zookeeper/config serverPath:/zookeeper/config finished:false header:: 2,4 replyHeader:: 2,177,-101 request:: '/zookeeper/config,T response::

11:09:34.629 [main-SendThread(127.0.0.1:2181)] DEBUG org.apache.zookeeper.ClientCnxn - Reading reply sessionid:0x10000c08f260001, packet:: clientPath:null serverPath:null finished:false header:: 3,15 replyHeader:: 3,-1,-6 request:: '/user,#74657374,v{s{31,s{'world,'anyone}}},0 response::

11:09:34.631 [main-SendThread(127.0.0.1:2181)] INFO org.apache.zookeeper.ClientCnxn - Unable to read additional data from server sessionid 0x10000c08f260001, likely server has closed socket, closing socket connection and attempting reconnect

Exception in thread "main" org.apache.zookeeper.KeeperException$UnimplementedException: KeeperErrorCode = Unimplemented for /user

at org.apache.zookeeper.KeeperException.create(KeeperException.java:103)

at org.apache.zookeeper.KeeperException.create(KeeperException.java:51)

at org.apache.zookeeper.ZooKeeper.create(ZooKeeper.java:1525)

at org.apache.curator.framework.imps.CreateBuilderImpl$17.call(CreateBuilderImpl.java:1181)

版本兼容参考

<dependencyManagement>

<dependencies>

<!-- zookeeper -->

<dependency>

<groupId>org.apache.curator</groupId>

<artifactId>curator-recipes</artifactId>

<version>2.13.0</version>

</dependency>

<dependency>

<groupId>org.apache.zookeeper</groupId>

<artifactId>zookeeper</artifactId>

<version>3.4.14</version>

</dependency>

</dependencies>

</dependencyManagement>

CRUD 基本操作示例

/**

* 基本操作

*/

public class ZookeeperCuratorDemo1 {

/**

* Curator中常用的API示例

*/

public static void main(String[] args) throws Exception {

// Zookeeper集群地址,多个节点地址可以用逗号分隔

String zkAddress = "127.0.0.1:2181";

// 重试策略:如果连接不上ZooKeeper集群,会重试三次,重试间隔会递增

RetryPolicy retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建Curator Client并启动,启动成功之后,就可以与Zookeeper进行交互

CuratorFramework client = CuratorFrameworkFactory.newClient(zkAddress, retryPolicy);

client.start();

// ① 创建一个名为"user"的持久节点,其中会存储一个test字符串(create()方法创建ZNode,可以调用额外方法来设置节点类型、添加Watcher)

String path = client.create().withMode(CreateMode.PERSISTENT).forPath("/user", "test".getBytes());

System.out.println(path); // 输出:/user

// ② checkExists()方法可以检查一个节点是否存在

Stat stat = client.checkExists().forPath("/user");

System.out.println(stat != null); // 输出:true,返回的Stat不为null,即表示节点存在

// ③ getData()方法可以获取一个节点中的数据

byte[] data = client.getData().forPath("/user");

System.out.println(new String(data)); // 输出:test

// ④ setData()方法可以设置一个节点中的数据

stat = client.setData().forPath("/user", "data".getBytes());

data = client.getData().forPath("/user");

System.out.println(new String(data)); // 输出:data

// ⑤ 在/user节点下,创建多个临时顺序节点

for (int i = 0; i < 3; i++) {

client.create().withMode(CreateMode.EPHEMERAL_SEQUENTIAL).forPath("/user/child-");

}

// ⑥ 获取所有子节点

List<String> children = client.getChildren().forPath("/user");

System.out.println(children); // 输出:[child-0000000002, child-0000000001, child-0000000000]

// ⑦ delete()方法可以删除指定节点,deletingChildrenIfNeeded()方法 会级联删除子节点

client.delete().deletingChildrenIfNeeded().forPath("/user");

}

}

(2)Background (异步处理):BackgroundCallback 、CuratorListener

上述的创建、删除、更新、读取等方法都是同步的,Curator 提供异步接口,引入了BackgroundCallback 这个回调接口以及 CuratorListener 这个监听器,用于处理 Background 调用之后服务端返回的结果信息。BackgroundCallback 接口和 CuratorListener 监听器中接收一个 CuratorEvent 的参数,里面包含事件类型、响应码、节点路径等详细信息。通过一个示例说明 BackgroundCallback 接口以及 CuratorListener 监听器的基本使用

/**

* 基本操作

*/

public class ZookeeperCuratorDemo2 {

/**

* Background

*/

public static void main(String[] args) throws Exception {

// Zookeeper集群地址,多个节点地址可以用逗号分隔

String zkAddress = "127.0.0.1:2181";

// 重试策略,如果连接不上ZooKeeper集群,会重试三次,重试间隔会递增

RetryPolicy retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建Curator Client并启动,启动成功之后,就可以与Zookeeper进行交互

CuratorFramework client = CuratorFrameworkFactory.newClient(zkAddress, retryPolicy);

client.start();

// 添加CuratorListener监听器,针对不同的事件进行处理

client.getCuratorListenable().addListener(new CuratorListener() {

public void eventReceived(CuratorFramework client, CuratorEvent event) throws Exception {

switch (event.getType()) {

case CREATE:

System.out.println("CREATE:" + event.getPath());

break;

case DELETE:

System.out.println("DELETE:" + event.getPath());

break;

case EXISTS:

System.out.println("EXISTS:" + event.getPath());

break;

case GET_DATA:

System.out.println("GET_DATA:" + event.getPath() + "," + new String(event.getData()));

break;

case SET_DATA:

System.out.println("SET_DATA:" + new String(event.getData()));

break;

case CHILDREN:

System.out.println("CHILDREN:" + event.getPath());

break;

default:

}

}

});

/**

* Background 操作,转化为后台操作:下面示例操作都添加了inBackground()方法,转换为后台操作

*/

client.create().withMode(CreateMode.PERSISTENT).inBackground().forPath("/user", "test".getBytes());

client.checkExists().inBackground().forPath("/user");

client.setData().inBackground().forPath("/user", "setData-Test".getBytes());

client.getData().inBackground().forPath("/user");

for (int i = 0; i < 3; i++) {

client.create().withMode(CreateMode.EPHEMERAL_SEQUENTIAL).inBackground().forPath("/user/child-");

}

client.getChildren().inBackground().forPath("/user");

// 添加BackgroundCallback

client.getChildren().inBackground(new BackgroundCallback() {

public void processResult(CuratorFramework client, CuratorEvent event) throws Exception {

System.out.println("in background:" + event.getType() + "," + event.getPath());

}

}).forPath("/user");

client.delete().deletingChildrenIfNeeded().inBackground().forPath("/user");

System.in.read();

}

}

/**

* output:

* CREATE:/user

* EXISTS:/user

* GET_DATA:/user,setData-Test

* CREATE:/user/child-

* CREATE:/user/child-

* CREATE:/user/child-

* CHILDREN:/user

* in background:CHILDREN,/user

* DELETE:/user

*/

(3)连接状态监听ConnectionStateListener

除了基础的数据操作,Curator 还提供了监听连接状态的监听器——ConnectionStateListener,它主要是处理 Curator 客户端和 ZooKeeper 服务器间连接的异常情况,例如, 短暂或者长时间断开连接。

短暂断开连接时,ZooKeeper 客户端会检测到与服务端的连接已经断开,但是服务端维护的客户端 Session 尚未过期,之后客户端和服务端重新建立了连接;当客户端重新连接后,由于 Session 没有过期,ZooKeeper 能够保证连接恢复后保持正常服务

而长时间断开连接时,Session 已过期,与先前 Session 相关的 Watcher 和临时节点都会丢失。当 Curator 重新创建了与 ZooKeeper 的连接时,会获取到 Session 过期的相关异常,Curator 会销毁老 Session,并且创建一个新的 Session。由于老 Session 关联的数据不存在了,在 ConnectionStateListener 监听到 LOST 事件时,就可以依靠本地存储的数据恢复 Session

此处 Session 指的是 ZooKeeper 服务器与客户端的会话。客户端启动的时候会与服务器建立一个 TCP 连接,从第一次连接建立开始,客户端会话的生命周期也开始了。客户端能够通过心跳检测与服务器保持有效的会话,也能够向 ZooKeeper 服务器发送请求并接受响应,同时还能够通过该连接接收来自服务器的 Watch 事件通知。

可以设置客户端会话的超时时间(sessionTimeout),当服务器压力太大、网络故障或是客户端主动断开连接等原因导致连接断开时,只要客户端在 sessionTimeout 规定的时间内能够重新连接到 ZooKeeper 集群中任意一个实例,那么之前创建的会话仍然有效。ZooKeeper 通过 sessionID 唯一标识 Session,所以在 ZooKeeper 集群中,sessionID 需要保证全局唯一。 由于 ZooKeeper 会将 Session 信息存放到硬盘中,即使节点重启,之前未过期的 Session 仍然会存在。

/**

* 基本操作

*/

public class ZookeeperCuratorDemo3 {

/**

* ConnectionStateListener 连接状态监听

*/

public static void main(String[] args) throws Exception {

// Zookeeper集群地址,多个节点地址可以用逗号分隔

String zkAddress = "127.0.0.1:2181";

// 重试策略,如果连接不上ZooKeeper集群,会重试三次,重试间隔会递增

RetryPolicy retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建Curator Client并启动,启动成功之后,就可以与Zookeeper进行交互

CuratorFramework client = CuratorFrameworkFactory.newClient(zkAddress, retryPolicy);

client.start();

// 添加ConnectionStateListener监听器

client.getConnectionStateListenable().addListener(new ConnectionStateListener() {

public void stateChanged(CuratorFramework client, ConnectionState newState) {

// 此处可以针对不同的连接状态进行特殊的处理

switch (newState) {

case CONNECTED:

// 第一次成功连接到ZooKeeper之后会进入该状态,对于每个CuratorFramework对象,此状态仅出现一次

break;

case SUSPENDED:

// ZooKeeper的连接丢失

break;

case RECONNECTED:

// 丢失的连接被重新建立

break;

case LOST:

// 当Curator认为会话已经过期时,则进入此状态

break;

case READ_ONLY:

// 连接进入只读模式

break;

}

}

});

}

}

(4)Wathcer(监听机制)

Watcher 监听机制是 ZooKeeper 中非常重要的特性,可以监听某个节点上发生的特定事件,例如,监听节点数据变更、节点删除、子节点状态变更等事件。当相应事件发生时,ZooKeeper 会产生一个 Watcher 事件,并且发送到客户端。通过 Watcher 机制,就可以使用 ZooKeeper 实现分布式锁、集群管理等功能。

在 Curator 客户端中,可以使用 usingWatcher() 方法添加 Watcher,前面示例中能够添加 Watcher 的有 checkExists()、getData()以及 getChildren() 三个方法

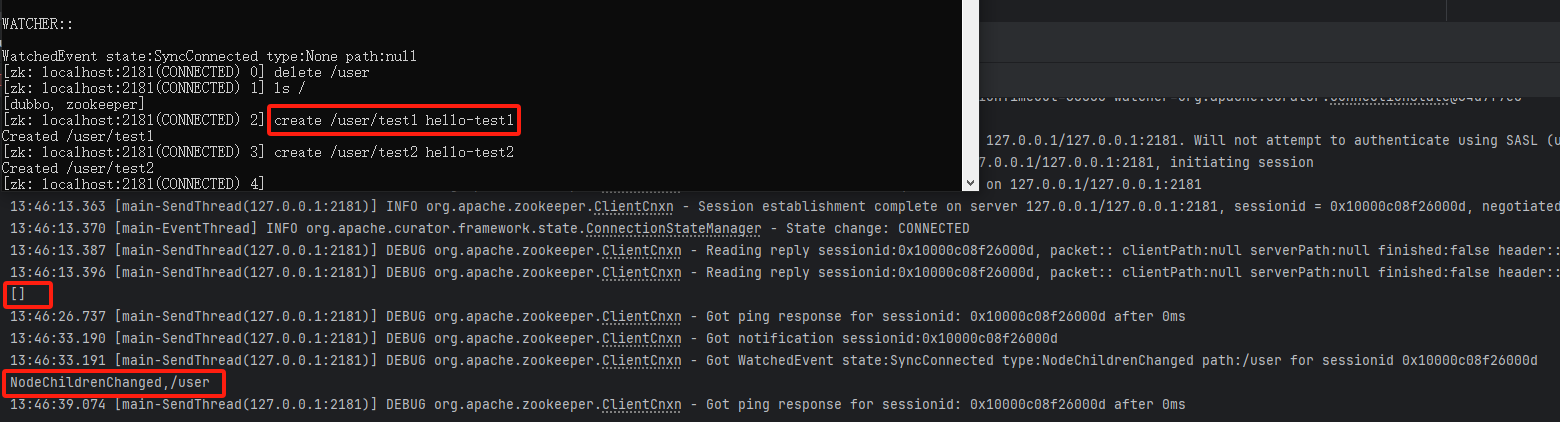

启动上述main示例,随后通过zookeeper命令行客户端,在user下先后添加两个子节点。可以看到控制台输出NodeChildrenChanged,/user,是因为通过 usingWatcher() 方法添加的 CuratorWatcher 只会触发一次,触发完毕后就会销毁。checkExists() 方法、getData() 方法通过 usingWatcher() 方法添加的 Watcher 也是一样的原理,只不过监听的事件不同

WatchedEvent state:SyncConnected type:None path:null

[zk: localhost:2181(CONNECTED) 0] delete /user

[zk: localhost:2181(CONNECTED) 1] ls /

[dubbo, zookeeper]

[zk: localhost:2181(CONNECTED) 2] create /user/test1 hello-test1

Created /user/test1

[zk: localhost:2181(CONNECTED) 3] create /user/test2 hello-test2

Created /user/test2

[zk: localhost:2181(CONNECTED) 4]

直接通过注册 Watcher 进行事件监听不是特别方便,需要自己反复注册 Watcher。Apache Curator 引入了 Cache 来实现对 ZooKeeper 服务端事件的监听。Cache 是 Curator 中对事件监听的包装,其对事件的监听其实可以近似看作是一个本地缓存视图和远程 ZooKeeper 视图的对比过程。同时,Curator 能够自动为开发人员处理反复注册监听,从而大大简化了代码的复杂程度。实践中常用的 Cache 有三大类:

- NodeCache:对一个节点进行监听,监听事件包括指定节点的增删改操作。注意,NodeCache 不仅可以监听数据节点的内容变更,也能监听指定节点是否存在,如果原本节点不存在,那么 Cache 就会在节点被创建后触发 NodeCacheListener,删除操作亦然

- PathChildrenCache:对指定节点的一级子节点进行监听,监听事件包括子节点的增删改操作,但是不对该节点的操作监听

- TreeCache:综合 NodeCache 和 PathChildrenCache 的功能,是对指定节点以及其子节点进行监听,同时还可以设置监听的深度

/**

* 基本操作

*/

public class ZookeeperCuratorDemo5 {

/**

* Watcher 监听机制

*/

public static void main(String[] args) throws Exception {

// Zookeeper集群地址,多个节点地址可以用逗号分隔

String zkAddress = "127.0.0.1:2181";

// 重试策略,如果连接不上ZooKeeper集群,会重试三次,重试间隔会递增

RetryPolicy retryPolicy = new ExponentialBackoffRetry(1000, 3);

// 创建Curator Client并启动,启动成功之后,就可以与Zookeeper进行交互

CuratorFramework client = CuratorFrameworkFactory.newClient(zkAddress, retryPolicy);

client.start();

// 创建NodeCache,监听的是"/user"这个节点

NodeCache nodeCache = new NodeCache(client, "/user");

// start()方法有个boolean类型的参数(默认是false)。如果设置为true,那么NodeCache在第一次启动的时候就会立刻从ZooKeeper上读取对应节点的数据内容,并保存在Cache中。

nodeCache.start(true);

if (nodeCache.getCurrentData() != null) {

System.out.println("NodeCache节点初始化数据为:" + new String(nodeCache.getCurrentData().getData()));

} else {

System.out.println("NodeCache节点数据为空");

}

// 添加监听器

nodeCache.getListenable().addListener(() -> {

String data = new String(nodeCache.getCurrentData().getData());

System.out.println("NodeCache节点路径:" + nodeCache.getCurrentData().getPath() + ",节点数据为:" + data);

});

// 创建PathChildrenCache实例,监听的是"user"这个节点

PathChildrenCache childrenCache = new PathChildrenCache(client, "/user", true);

/**

* StartMode指定的初始化的模式:

* ① NORMAL:普通异步初始化

* ② BUILD_INITIAL_CACHE:同步初始化

* ③ POST_INITIALIZED_EVENT:异步初始化,初始化之后会触发事件

*/

childrenCache.start(PathChildrenCache.StartMode.BUILD_INITIAL_CACHE);

// childrenCache.start(PathChildrenCache.StartMode.POST_INITIALIZED_EVENT);

// childrenCache.start(PathChildrenCache.StartMode.NORMAL);

List<ChildData> children = childrenCache.getCurrentData();

System.out.println("获取子节点列表:");

// 如果是BUILD_INITIAL_CACHE可以获取这个数据,如果不是就不行

children.forEach(childData -> {

System.out.println(new String(childData.getData()));

});

childrenCache.getListenable().addListener(((client1, event) -> {

System.out.println(LocalDateTime.now() + " " + event.getType());

if (event.getType().equals(PathChildrenCacheEvent.Type.INITIALIZED)) {

System.out.println("PathChildrenCache:子节点初始化成功...");